Já estamos acostumados ao fato de que as máquinas podem reconhecer o que veem em fotos e vídeos. Essa capacidade é baseada em grandes conjuntos de dados como o ImageNet, uma coleção de milhões de fotos meticulosamente selecionadas que é usada para treinar boa parte dos melhores modelos de reconhecimento de imagem da última década.

Mas as imagens nesses conjuntos de dados retratam um mundo seleto de objetos, uma galeria de imagens que não captura a bagunça da vida cotidiana como os humanos a experimentam. Para fazer com que as máquinas vejam as coisas como as vemos, uma abordagem totalmente nova será necessária. E o laboratório de Inteligência Artificial (IA) do Facebook quer ser o pioneiro.

A empresa está lançando um projeto, chamado Ego4D, para construir IAs que possam entender cenas e atividades vistas de uma perspectiva de primeira pessoa, ou seja, como veem os participantes, em vez de como um observador veria. Pense em imagens borradas da GoPro de movimentos em ação, em vez de cenas nitidamente focadas filmadas por alguém nos bastidores. O Facebook quer que o Ego4D faça pelo vídeo em primeira pessoa o que o ImageNet fez pelas fotos.

Nos últimos dois anos, o Facebook AI Research (FAIR) trabalhou com 13 universidades em todo o mundo para reunir o maior conjunto de dados de vídeo em primeira pessoa já feito, especificamente para treinar modelos de reconhecimento de imagem de deep learning. As IAs treinadas pelo conjunto de dados serão melhores no controle de robôs que interajam com pessoas ou na interpretação de imagens de óculos inteligentes. “As máquinas só poderão nos ajudar em nosso dia a dia se realmente entenderem o mundo através de nossos olhos”, diz Kristen Grauman, que lidera o projeto do FAIR.

Essa tecnologia pode auxiliar pessoas que precisem de ajuda em casa ou orientar as pessoas em tarefas que estejam aprendendo a realizar. “Os vídeos reunidos neste conjunto de dados estão muito mais próximos de como os humanos observam o mundo”, diz Michael Ryoo, um pesquisador de visão computacional do Google Brain e da Stony Brook University em Nova York, que não está envolvido no Ego4D.

Contudo, os potenciais usos indevidos são nítidos e preocupantes. A pesquisa é financiada pelo Facebook, um gigante das redes sociais que foi recentemente acusado pelo Senado dos Estados Unidos de priorizar os lucros em detrimento do bem-estar das pessoas, conforme corroborado pelas investigações do MIT Technology Review.

O modelo de negócios do Facebook e de outras gigantes da tecnologia é extrair o máximo possível de dados do comportamento online das pessoas e vendê-los aos publicitários. A IA delineada no projeto pode estender essa prática ao comportamento off-line diário das pessoas, revelando quais objetos estão em sua casa, de quais atividades você gostou, com quem você passou o tempo e até mesmo onde seu olhar se fixou — um nível sem precedentes de informações pessoais.

“Há muito que precisa ser trabalhado quanto às questões de privacidade à medida que tiramos isso do mundo da pesquisa exploratória e transformamos em algo que é um produto”, diz Grauman. “Esse trabalho poderia até ser inspirado por este projeto”.

FACEBOOK

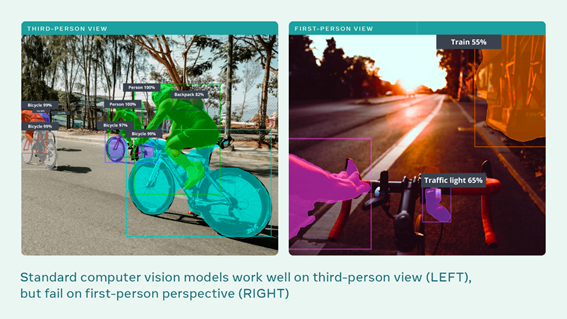

Visão em terceira pessoa

Semáforo 65%

Trem 55%

Visão em primeira pessoa

Mochila 82%

Bicicleta 99%

Bicicleta 97%

Pessoa 100%

Pessoa 100%

Bicicleta 99%

Bicicleta 99%

Os modelos de visão computacional padrão funcionam bem na perspectiva de terceira pessoa (ESQUERDA), mas falham na de primeira pessoa (DIREITA).

Anteriormente, o maior conjunto de dados de vídeo em primeira pessoa consistia em 100 horas de filmagem de pessoas na cozinha. O conjunto de dados Ego4D consiste em 3.025 horas de vídeo, gravados por 855 pessoas em 73 locais diferentes e em nove países (EUA, Reino Unido, Índia, Japão, Itália, Singapura, Arábia Saudita, Colômbia e Ruanda).

Os participantes tinham diferentes idades e origens; alguns foram recrutados por suas profissões visualmente interessantes, como padeiros, mecânicos, carpinteiros e paisagistas.

Os conjuntos de dados anteriores normalmente consistiam em clipes de vídeo parcialmente roteirizados que duravam apenas alguns segundos. Para o Ego4D, os participantes usaram câmeras em suas cabeças por até 10 horas seguidas e capturaram vídeos em primeira pessoa de atividades diárias não roteirizadas, incluindo caminhar por uma rua, ler, lavar roupa, fazer compras, brincar com animais de estimação, jogar jogos de tabuleiro e interagir com outras pessoas. Algumas das filmagens também incluem áudio, dados sobre onde o olhar dos participantes estava focado e várias perspectivas diferentes da mesma cena. É o primeiro conjunto de dados desse tipo, diz Ryoo.

O FAIR também lançou uma série de desafios, na esperança de inspirar outros pesquisadores a desenvolver este tipo de IA. A equipe prevê algoritmos integrados em óculos inteligentes, como os recém anunciados óculos Ray-Ban do Facebook, que gravam e registram o dia a dia dos usuários. Isso significa que aplicativos de realidade aumentada ou virtual do “metaverso” poderiam, em teoria, responder a perguntas como “Onde estão as chaves do meu carro?” ou “O que eu comi e do lado de quem sentei no meu primeiro voo para a França?” Assistentes de realidade aumentada podem entender o que estamos tentando fazer e oferecer instruções ou dicas úteis.

É coisa de ficção científica, mas, segundo Grauman, está mais perto do que se imagina. Grandes conjuntos de dados aceleram as pesquisas. “A ImageNet trouxe grandes avanços em pouco tempo”, diz ela. “Podemos esperar o mesmo do Ego4D, mas para visualizações do mundo em primeira pessoa, em vez de imagens da Internet”.

Após a coleta da filmagem, trabalhadores voluntários em Ruanda passaram um total de 250.000 horas assistindo os milhares de videoclipes e escrevendo milhões de frases que descrevem as cenas e atividades filmadas. Essas anotações serão usadas para treinar IAs para que elas possam entender o que estão vendo.

Ainda não se sabe onde essa tecnologia será usada e com que rapidez se desenvolverá. O FAIR está planejando uma competição baseada em seus desafios para junho de 2022. Também é importante notar que o FAIR, laboratório de pesquisa, não é a mesma coisa que o Facebook, o gigante da rede social. Na verdade, especialistas dizem que o Facebook ignorou correções técnicas criadas pelo FAIR para seus algoritmos tóxicos. Entretanto, o Facebook está pagando pela pesquisa e é ingênuo acreditar que não tem interesse em aplicar seus resultados.

Sam Gregory, da Witness, uma organização de direitos humanos especializada em tecnologia de vídeo, diz que essa tecnologia pode ser útil para espectadores documentando protestos ou abusos da polícia. Mas ele acredita que esses benefícios são sobrepujados por preocupações com aplicações comerciais. Ele observa que é possível identificar os indivíduos pela maneira como seguram uma câmera de vídeo. Os dados do olhar seriam ainda mais reveladores: “É um indicador de interesse muito forte”, diz ele. “Como os dados do olhar serão armazenados? Quem terá acesso? Como podem ser processados e usados?”

“A reputação e o principal modelo de negócios do Facebook causam muita preocupação”, diz Rory Mir da Electronic Frontier Foundation. “Atualmente, muitos estão cientes da péssima relação que o Facebook tem com a privacidade dos usuários e de seu uso de vigilância para influenciá-los, tanto para mantê-los viciados na plataforma quanto para vender tal influência para seus clientes pagantes, os publicitários”. Quando se trata de realidade aumentada e virtual, o Facebook está em busca de uma vantagem competitiva, diz Mir: “Expandir a quantidade e os tipos de dados que coleta é essencial”.

Como era de se esperar, quando questionado sobre seus planos, o Facebook se manteve calado: “O Ego4D é apenas pesquisa para promover avanços na comunidade científica como um todo”, disse um porta-voz. “No momento, não temos nada para compartilhar sobre aplicação de produtos ou uso comercial”.