O Google DeepMind anunciou um impressionante conjunto de novos produtos e protótipos que podem ajudá-lo a recuperar sua liderança na corrida para transformar a Inteligência Artificial generativa em uma solução de massa.

O grande destaque é o Gemini 2.0 — a mais recente versão da família de modelos de linguagem multimodais do Google DeepMind, agora redesenhada com foco na capacidade de controlar agentes — e uma nova versão do Projeto Astra, o app experimental “tudo em um” que a empresa apresentou no evento Google I/O em maio.

A MIT Technology Review teve a oportunidade de testar o Astra em uma demonstração fechada. A experiência foi impressionante, mas há uma diferença significativa entre um vídeo promocional polido e uma demonstração ao vivo.

O Astra utiliza o framework de agentes integrado ao Gemini 2.0 para responder a perguntas e realizar tarefas por meio de texto, fala, imagem e vídeo, conectando-se a aplicativos do Google como Search, Maps e Lens sempre que necessário. “Estamos combinando alguns dos sistemas de recuperação de informações mais poderosos do nosso tempo”, diz Bibo Xu, gerente de produto do Astra.

O Gemini 2.0 e o Astra são acompanhados pelo Mariner, um novo agente que pode navegar na web para você; o Jules, um assistente de programação alimentado pelo Gemini; e o Gemini for Games, um assistente experimental que pode oferecer dicas enquanto você joga videogames.

(E vale lembrar que o Google DeepMind também anunciou o Veo, um modelo de geração de vídeo; o Imagen 3, a nova versão de seu modelo de geração de imagens; e o Willow, um novo tipo de chip para computadores quânticos. Ufa! Enquanto isso, o CEO Demis Hassabis estava ontem na Suécia recebendo seu Prêmio Nobel.)

O Google DeepMind afirma que o Gemini 2.0 é duas vezes mais rápido que a versão anterior, o Gemini 1.5, e supera seu antecessor em vários benchmarks padrão, incluindo o MMLU-Pro, um extenso conjunto de questões de múltipla escolha usado para testar as habilidades de grandes modelos de linguagem em diversas áreas, de matemática e física até saúde, psicologia e filosofia.

Porém, as diferenças entre os principais modelos, como o Gemini 2.0 e os desenvolvidos por laboratórios concorrentes, como OpenAI e Anthropic, são agora muito pequenas. Atualmente, os avanços em modelos de linguagem não se referem tanto à qualidade em si, mas ao que é possível fazer com eles.

E é aí que entram os agentes.

Hands-on com o Projeto Astra

Fui levado por uma porta discreta em um andar superior de um prédio no distrito de King’s Cross, em Londres, até uma sala que transmitia fortes vibrações de “projeto secreto”. A palavra “ASTRA” estava estampada em letras gigantes em uma das paredes. O cachorro de Xu, Charlie — o mascote não oficial do projeto —, passeava entre as mesas onde pesquisadores e engenheiros trabalhavam na construção do produto no qual o Google aposta o seu futuro.

“A forma como explico para a minha mãe é que estamos criando uma IA com olhos, ouvidos e voz. Ela pode estar em qualquer lugar com você e ajudar em qualquer coisa que você estiver fazendo”, diz Greg Wayne, um dos líderes da equipe do Astra. “Ainda não chegamos lá, mas essa é a visão.”

O termo oficial para o que Xu, Wayne e seus colegas estão desenvolvendo é “assistente universal”. Eles ainda estão definindo exatamente o que isso significa.

No extremo da sala do Astra, havia dois cenários usados para demonstrações: um bar de drinks e uma galeria de arte simulada. Xu me levou ao bar primeiro. “Há muito tempo, contratamos um especialista em coquetéis para nos ensinar a preparar drinks,” disse Praveen Srinivasan, outro líder do projeto. “Gravamos essas conversas e usamos isso para treinar nosso modelo inicial.”

Xu abriu um livro de receitas em uma página com a receita de um frango ao curry, apontou o celular para ela e ativou o Astra.

“Ni hao, Bibo!” disse uma voz feminina.

“Ah! Por que você está falando comigo em mandarim?” Xu perguntou ao celular. “Pode falar comigo em inglês, por favor?”

“Minhas desculpas, Bibo. Eu estava seguindo uma instrução anterior para falar em mandarim. Agora falarei em inglês, conforme solicitado.”

O Astra lembra conversas anteriores, explicou Xu. Ele também mantém na memória os últimos 10 minutos de vídeo. (No vídeo promocional lançado pelo Google em maio, há um momento impressionante em que o Astra diz à pessoa onde ela havia deixado os óculos, tendo-os visto em uma mesa segundos antes. Mas eu não vi nada parecido durante a demonstração ao vivo.)

Voltando ao livro de receitas. Movendo a câmera do celular sobre a página por alguns segundos, Xu pediu ao Astra que lesse a receita e dissesse quais especiarias estavam na lista.

“Lembro que a receita menciona uma colher de chá de pimenta-do-reino em grãos, uma colher de chá de pimenta em pó e um pau de canela”, respondeu.

“Acho que você está esquecendo algumas coisas”, disse Xu. “Dê outra olhada.”

“Você está correta — peço desculpas. Também vejo açafrão em pó e folhas de curry entre os ingredientes.”

Assistindo a essa tecnologia em ação, duas coisas ficam claras imediatamente. Primeiro, ela ainda apresenta falhas e precisa ser corrigida. Segundo, essas falhas podem ser facilmente ajustadas com algumas palavras. Basta interromper a voz, repetir as instruções e seguir em frente. Parece mais como orientar uma criança do que lidar com um software quebrado.

Em seguida, Xu apontou o celular para uma fileira de garrafas de vinho e pediu ao Astra que escolhesse uma que combinasse com o frango ao curry. Ele sugeriu um rioja e explicou o motivo. Xu perguntou quanto custava a garrafa. O Astra respondeu que precisaria usar o Search para consultar os preços online. Alguns segundos depois, retornou com a resposta.

Mudamos para a galeria de arte, onde Xu mostrou ao Astra uma série de telas com pinturas famosas: a Mona Lisa, O Grito de Munch, um Vermeer, um Seurat, entre outras.

“Ni hao, Bibo!” a voz disse novamente.

“Você está falando comigo em mandarim de novo,” disse Xu. “Fale comigo em inglês, por favor.”

“Minhas desculpas, parece que entendi errado. Sim, responderei em inglês.” (Eu deveria saber melhor, mas juro que senti um leve tom irônico.)

Era a minha vez. Xu me entregou o celular dela.

Tentei colocar o Astra em uma situação difícil, mas ele não cedeu. Perguntei em qual famosa galeria de arte estávamos, mas ele se recusou a arriscar um palpite. Perguntei por que havia identificado as pinturas como réplicas, e ele começou a se desculpar pelo erro (o Astra se desculpa muito). Fui obrigado a interromper: “Não, não—você está certo, não é um erro. Você está correto em identificar pinturas em telas como falsas.” Não pude deixar de me sentir um pouco mal: eu havia confundido um aplicativo que existe apenas para agradar.

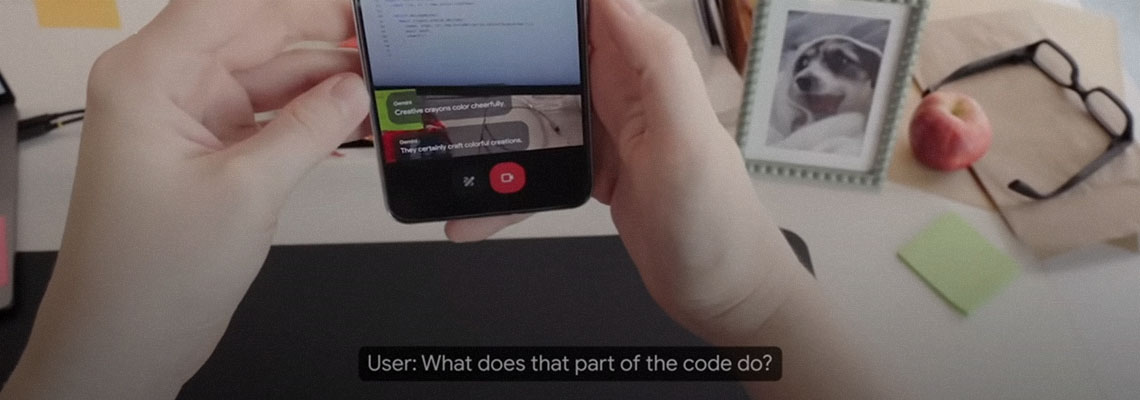

Quando funciona bem, o Astra é fascinante. A experiência de iniciar uma conversa com o seu telefone sobre qualquer coisa que você estiver apontando parece nova e fluida. Em uma coletiva de imprensa realizada ontem, o Google DeepMind exibiu um vídeo mostrando outros usos do Astra: ler um e-mail na tela do celular para encontrar um código de acesso (e lembrá-lo mais tarde), apontar o celular para um ônibus em movimento e perguntar para onde ele está indo, ou fazer perguntas sobre uma obra de arte pública enquanto você passa por ela. Isso pode se tornar o grande killer app da IA generativa.

Porém, ainda há um longo caminho até que a maioria das pessoas tenha acesso a uma tecnologia como essa. Não há menção a uma data de lançamento. O Google DeepMind também compartilhou vídeos do Astra funcionando em um par de óculos inteligentes, mas essa tecnologia está ainda mais distante na lista de prioridades da empresa.

Misturando as peças

Por enquanto, pesquisadores externos ao Google DeepMind estão observando de perto o progresso do Astra. “A maneira como as coisas estão sendo combinadas é impressionante”, diz Maria Liakata, especialista em grandes modelos de linguagem na Queen Mary University of London e no Alan Turing Institute. “Já é difícil fazer raciocínio apenas com linguagem, mas aqui é preciso integrar imagens e outros elementos. Isso não é trivial.”

Liakata também ficou impressionada com a capacidade do Astra de lembrar coisas que ele viu ou ouviu. Ela trabalha com o que chama de contexto de longo prazo, desenvolvendo modelos para acompanhar informações com as quais tiveram contato anteriormente. “Isso é empolgante,” diz Liakata. “Mesmo conseguir fazer isso em uma única modalidade já é algo impressionante.”

Porém, ela admite que grande parte de sua análise envolve suposições. “O raciocínio multimodal é algo extremamente avançado,” diz ela. “Mas é muito difícil saber exatamente onde eles estão, porque não disseram muito sobre a tecnologia em si.”

Para Bodhisattwa Majumder, pesquisador que trabalha com modelos multimodais e agentes no Instituto Allen para IA, essa é uma preocupação central. “Não sabemos absolutamente como o Google está fazendo isso,” ele afirma.

Majumder destaca que, se o Google fosse um pouco mais transparente sobre o que está construindo, isso ajudaria os consumidores a entenderem as limitações da tecnologia que logo poderão ter em mãos. “As pessoas precisam saber como esses sistemas funcionam,” diz ele. “É importante que o usuário consiga ver o que o sistema aprendeu sobre ele, corrigir erros ou remover informações que deseja manter privadas.”

Liakata também se preocupa com as implicações para a privacidade, destacando que as pessoas poderiam ser monitoradas sem seu consentimento. “Há coisas que me empolgam e coisas que me preocupam,” ela diz. “Há algo perturbador no fato de o seu telefone se tornar os seus olhos.”

“O impacto que esses produtos terão na sociedade é tão grande que isso deveria ser levado mais a sério,” ela continua. “Mas isso se tornou uma corrida entre as empresas. Isso é problemático, especialmente porque não temos nenhum acordo sobre como avaliar essa tecnologia.”

O Google DeepMind afirma que analisa cuidadosamente questões de privacidade, segurança e proteção em todos os seus novos produtos. Sua tecnologia será testada por equipes de usuários de confiança durante meses antes de ser lançada ao público. “Obviamente, precisamos pensar no uso indevido. Precisamos pensar no que acontece quando algo dá errado,” diz Dawn Bloxwich, diretora de desenvolvimento responsável e inovação da empresa. “Há um enorme potencial. Os ganhos de produtividade são enormes. Mas também existem riscos.”

Nenhuma equipe de testes pode prever todas as formas como as pessoas usarão ou abusarão de uma nova tecnologia. Então, qual é o plano para quando o inevitável acontecer? As empresas precisam projetar produtos que possam ser desativados ou recolhidos rapidamente, caso necessário, afirma Bloxwich: “Se precisarmos fazer mudanças rápidas ou retirar algo de circulação, podemos fazer isso.”

Por:Will Douglas Heaven

Will é editor sênior de IA na MIT Technology Review, cobrindo assuntos sobre novas pesquisas, tendências e pessoas por trás dela.