Com empresas correndo contra o tempo para lançar programas como o GPT-3, grandes modelos de linguagem capazes de escrever textos e até mesmo códigos de computador impressionantemente coerentes, esta é uma das áreas da pesquisa de Inteligência Artificial (IA) mais em evidência no momento. Mas, de acordo com uma equipe de analistas de IA, há um problema surgindo no horizonte: podemos ficar sem dados para treiná-los.

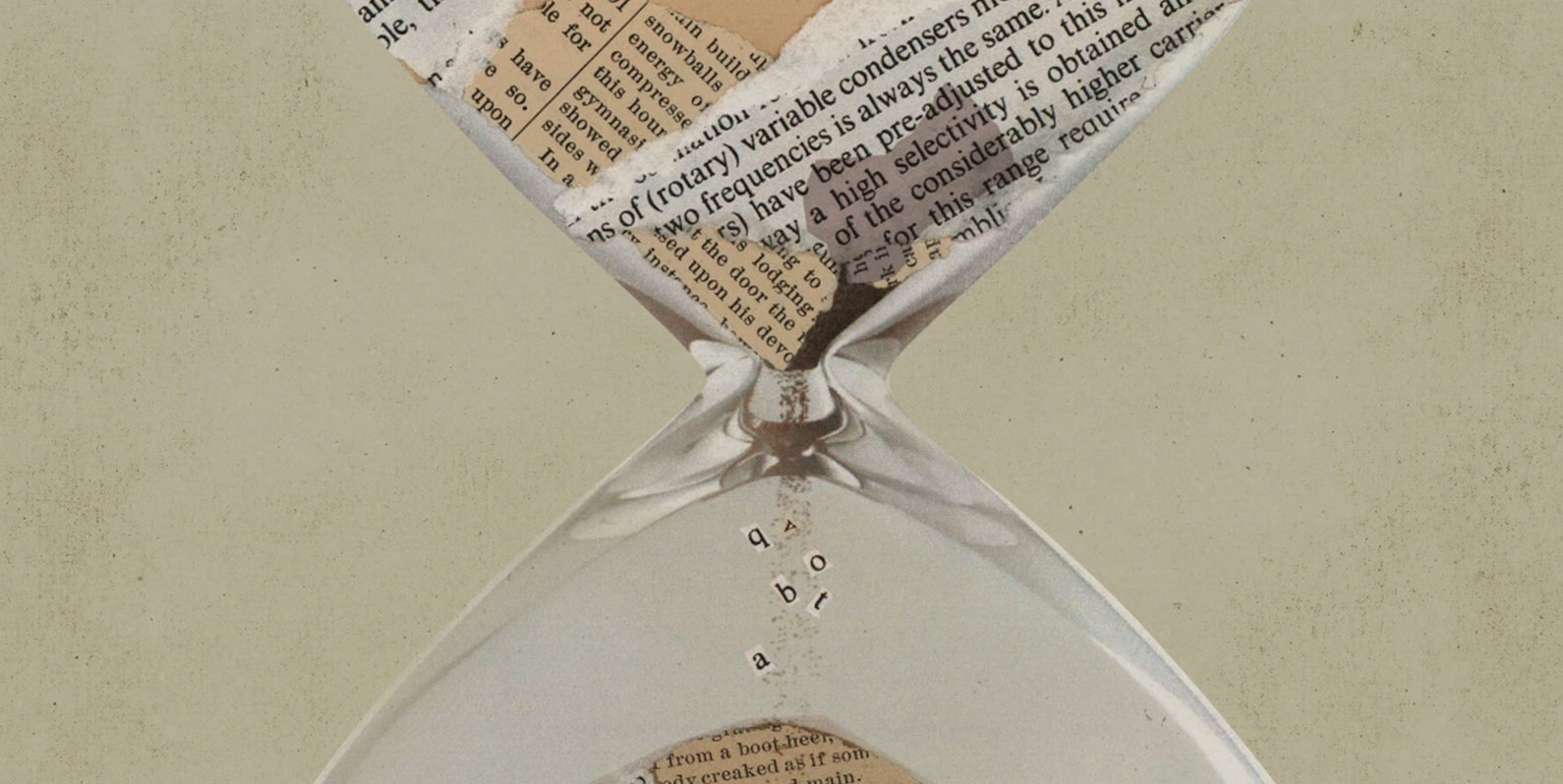

Os modelos de linguagem são treinados usando textos de fontes como Wikipédia, notícias de jornais e veículos de comunicação variados, artigos científicos e livros. Nos últimos anos, a tendência tem sido treinar esses modelos com mais e mais dados, na esperança de torná-los mais precisos e versáteis.

O problema é que os tipos de dados normalmente usados para este fim podem se esgotar em um futuro próximo. De acordo com um artigo de pesquisadores da Epoch, uma organização de pesquisa e projeção de cenários de IA, isso aconteceria já em 2026. O artigo, no entanto, ainda não foi revisado por pares. O problema, segundo os pesquisadores, decorre do fato de que, à medida que modelos mais poderosos e com maiores capacidades são construídos, também aumenta a necessidade de textos para serem usados nos treinamentos. Dessa forma, pesquisadores desses grandes modelos de linguagem estão cada vez mais preocupados com a possibilidade de ficar sem materiais, diz Teven Le Scao, pesquisador da empresa de IA, Hugging Face, que não esteve envolvido no trabalho da Epoch.

Isso acontece em parte porque os dados são filtrados em duas categorias para treinamento de modelos: alta qualidade e baixa qualidade. A linha entre essas duas divisões pode ser tênue, diz Pablo Villalobos, pesquisador da Epoch e principal autor do artigo, mas o tipo de texto avaliado como de alta qualidade é visto como um material melhor escrito e frequentemente produzido por escritores profissionais.

Já os dados da categoria de baixa qualidade consistem em textos como postagens de rede social ou comentários em sites como o 4chan, e esses materiais superam em muito o número daqueles da outra categoria. Normalmente, os pesquisadores usam em seus treinamentos apenas dados que se enquadram na categoria de alta qualidade porque esse é o tipo de linguagem que eles desejam que os modelos reproduzam. Essa prática resultou em grandes modelos de linguagem impressionantes, como GPT-3.

De acordo com Swabha Swayamdipta, professora de machine learning da Universidade do Sul da Califórnia (USC), nos Estados Unidos, especializada em qualidade de conjunto de dados, uma maneira de superar essas restrições seria reavaliar o que é definido como qualidade “baixa” e “alta”. Se a escassez de dados levar os pesquisadores de IA a incorporar conjuntos de dados mais diversos no processo de treinamento, então isso seria uma “rede positiva” para os modelos de linguagem, diz Swayamdipta.

Os pesquisadores também podem buscar por maneiras de estender a vida útil dos dados usados nos treinamentos de modelos de linguagem. Atualmente, eles são treinados com os mesmos dados apenas uma vez, devido a restrições de desempenho e custo. Mas pode ser possível treinar um modelo várias vezes usando os mesmos dados, diz Swayamdipta.

Alguns pesquisadores acreditam que não é porque um modelo de linguagem é grande que ele seja melhor. Percy Liang, professor de ciência da computação na Universidade de Stanford (EUA), diz que há evidências de que tornar os modelos mais eficientes pode melhorar sua capacidade, não apenas aumentar seu tamanho. “Vimos como modelos menores, mas treinados em dados de qualidade superior, podem sobrepujar modelos maiores treinados em dados de qualidade inferior”, explica ele.