O entusiasmo com o Gemini, a resposta do Google DeepMind ao GPT-4 da OpenAI, que há muito tempo é comentada, vem crescendo há meses. No começo do mês, a empresa finalmente revelou no que estava trabalhando em segredo durante todo esse tempo. O hype foi justificado? Sim e não.

O Gemini é o maior lançamento de IA do Google até o momento — seu esforço para enfrentar os concorrentes OpenAI e Microsoft na corrida pela supremacia da IA. Não há dúvida de que o modelo é apresentado como o melhor da categoria em uma ampla gama de recursos — uma “máquina para tudo”, como diz um observador.

“O modelo é inatamente mais capaz”, disse Sundar Pichai, CEO do Google e de sua empresa controladora, a Alphabet, à MIT Technology Review. “É uma plataforma. A IA é uma mudança profunda na plataforma, maior do que a Web ou o celular. Portanto, ela representa um grande passo para nós.”

É um grande passo para o Google, mas não necessariamente um salto gigantesco para o campo como um todo. O Google DeepMind afirma que o Gemini supera o GPT-4 em 30 das 32 medidas padrão de desempenho. E, no entanto, as margens entre eles são pequenas. O que o Google DeepMind fez foi reunir os melhores recursos atuais de IA em um pacote poderoso. A julgar pelas demonstrações, ele faz muitas coisas muito bem, mas poucas coisas que não tenham sido vistas antes. Apesar de todo o burburinho sobre a próxima grande novidade, o Gemini pode ser um sinal de que atingimos o ápice da empolgação com a IA. Pelo menos por enquanto.

Chirag Shah, professor da Universidade de Washington especializado em pesquisa online, compara o lançamento com o de um novo iPhone pela Apple todos os anos. “Talvez tenhamos chegado a um patamar diferente agora, em que isso não nos impressiona tanto porque já vimos muita coisa”, diz ele.

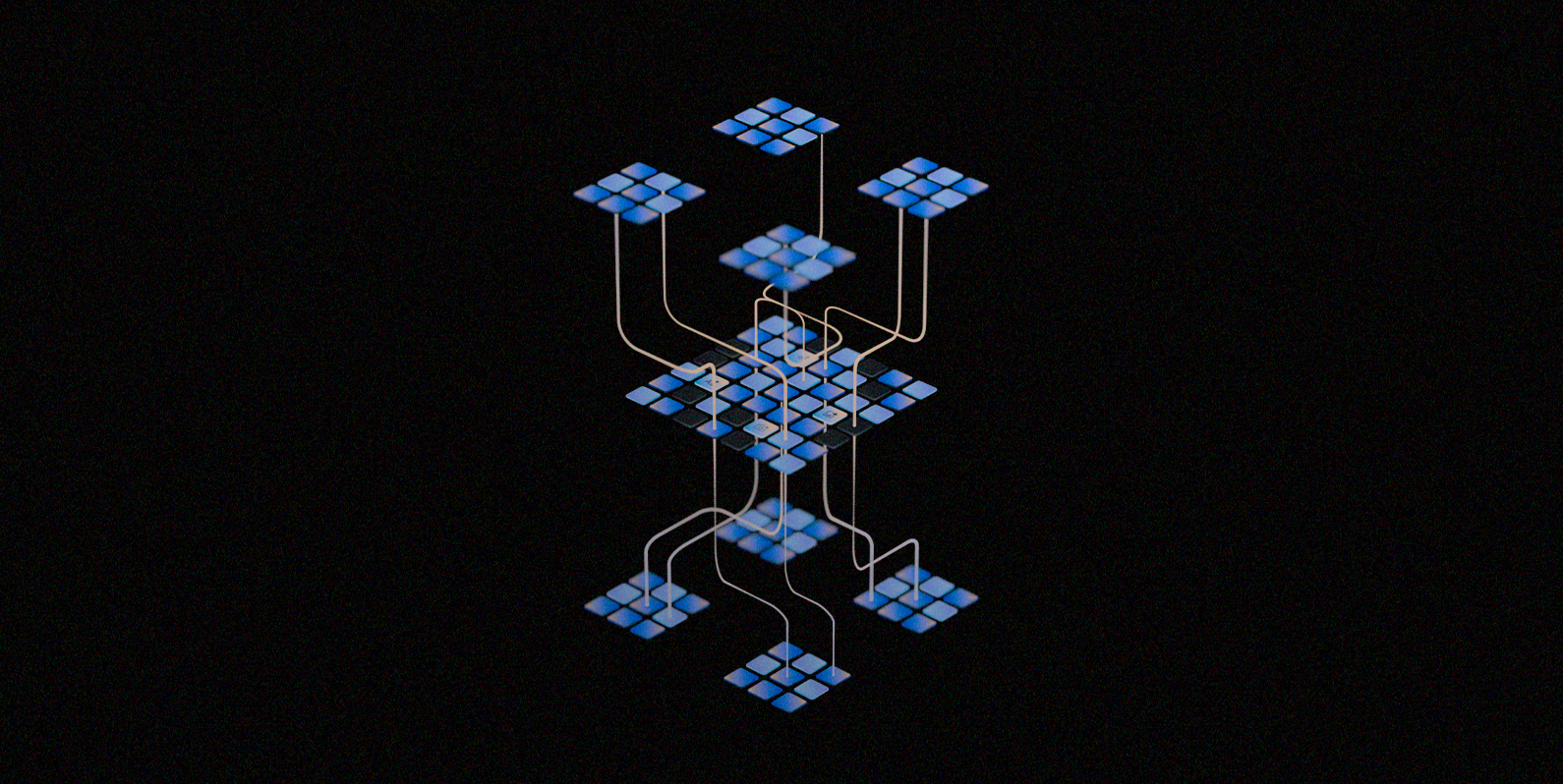

Assim como o GPT-4, o Gemini é multimodal, ou seja, é treinado para lidar com vários tipos de entrada: texto, imagens, áudio. Ele pode combinar esses diferentes formatos para responder a perguntas sobre qualquer assunto, desde tarefas domésticas até matemática universitária e economia.

Em uma demonstração para jornalistas, o Google mostrou a capacidade do Gemini de tirar uma captura de tela de um gráfico, analisar centenas de páginas de pesquisa com novos dados e atualizar o gráfico com essas novas informações. Em outro exemplo, são mostradas ao Gemini imagens de uma omelete sendo preparada em uma frigideira e é perguntado (usando fala, não texto) se a omelete já está cozida. “Não está pronta porque os ovos ainda estão escorrendo”, ele responde.

No entanto, a maioria das pessoas terá que esperar pela experiência completa. A versão lançada hoje é um back-end para o Bard, o chatbot de pesquisa baseado em texto do Google, que, segundo a empresa, dará a ele recursos mais avançados de raciocínio, planejamento e compreensão. O lançamento completo do Gemini será escalonado nos próximos meses. O novo Bard impulsionado pelo Gemini estará disponível inicialmente em inglês em mais de 170 países, não incluindo a UE e o Reino Unido. O objetivo é permitir que a empresa “se envolva” com os órgãos reguladores locais, diz Sissie Hsiao, vice-presidente do Google responsável pelo Bard.

O Gemini também está disponível em três tamanhos: Ultra, Pro e Nano. O Ultra é a versão com potência total; o Pro e o Nano são adaptados para aplicativos executados com recursos de computação mais limitados. O Nano foi projetado para ser executado em dispositivos, como os novos telefones Pixel do Google. Os desenvolvedores e as empresas já podem acessar o Gemini Pro. O Gemini Ultra, o modelo mais poderoso, estará disponível “no início do próximo ano”, após “extensas verificações de confiança e segurança”, disseram executivos do Google a repórteres em uma coletiva de imprensa.

“Penso nisso como a era Gemini dos modelos”, disse Pichai. “É assim que o Google DeepMind vai construir e progredir na IA. Portanto, ela sempre representará a fronteira de onde estamos progredindo na tecnologia de IA.”

Maior, melhor, mais rápido, mais forte?

O modelo mais poderoso da OpenAI, o GPT-4, é visto como o padrão ouro do setor. Embora o Google tenha se gabado de que o Gemini supera o modelo anterior da OpenAI, o GPT 3.5, os executivos da empresa se esquivaram de perguntas sobre até que ponto o modelo supera o GPT-4.

Mas a empresa destaca um benchmark em particular, chamado MMLU (massive multitask language understanding). Trata-se de um conjunto de testes criados para medir o desempenho de modelos em tarefas que envolvem texto e imagens, incluindo compreensão de leitura, matemática universitária e testes de múltipla escolha em física, economia e ciências sociais. Nas perguntas somente de texto, o Gemini obteve 90% de pontuação e os especialistas humanos obtiveram aproximadamente 89%, diz Pichai. O GPT-4 obteve 86% de pontuação nesses tipos de perguntas. Nas perguntas multimodais, o Gemini pontua 59%, enquanto o GPT-4 pontua 57%. “É o primeiro modelo a ultrapassar esse limite”, diz Pichai.

O desempenho do Gemini em relação aos conjuntos de dados de referência é muito impressionante, diz Melanie Mitchell, pesquisadora de Inteligência Artificial do Santa Fe Institute, no Novo México.

“É evidente que o Gemini é um sistema de IA muito sofisticado”, diz Mitchell. Mas “não é óbvio para mim que o Gemini seja de fato muito mais capaz do que o GPT-4”, acrescenta ela.

Embora o modelo tenha boas pontuações de benchmark, é difícil saber como interpretar esses números, pois não sabemos o que há nos dados de treinamento, diz Percy Liang, diretor do Center for Research on Foundation Models de Stanford.

Mitchell também observa que o Gemini tem um desempenho muito melhor em benchmarks de linguagem e código do que em imagens e vídeo. “Os modelos de base multimodal ainda têm um longo caminho a percorrer para serem úteis de forma geral e robusta para muitas tarefas”, diz ela.

Usando o feedback de testadores humanos, o Google DeepMind treinou o Gemini para ser mais preciso do ponto de vista factual, para dar atribuições quando solicitado e para se proteger em vez de cuspir bobagens quando confrontado com uma pergunta que não pode responder. A empresa alega que isso atenua o problema das alucinações. Mas, sem uma revisão radical da tecnologia de base, os modelos de linguagem de grande porte continuarão a inventar coisas.

Os especialistas afirmam que não está claro se os benchmarks que o Google está usando para medir o desempenho do Gemini oferecem tantos insights e, sem transparência, é difícil verificar as afirmações do Google.

“O Google está anunciando o Gemini como uma máquina completa – um modelo de uso geral que pode ser usado de muitas maneiras diferentes”, diz Emily Bender, professora de linguística computacional da Universidade de Washington. Mas a empresa está usando padrões de referência restritos para avaliar modelos que espera que sejam usados para essas diversas finalidades. “Isso significa que, efetivamente, não é possível fazer uma avaliação completa”, diz ela.

Em última análise, para o usuário comum, a melhoria incremental em relação aos modelos concorrentes pode não fazer muita diferença, diz Shah. “É mais uma questão de conveniência, reconhecimento da marca, integração existente, do que de as pessoas realmente pensarem ‘Ah, isso é melhor'”, diz ele.

Um desenvolvimento longo e lento

A chegada do Gemini foi muito demorada. Em abril de 2023, o Google anunciou que estava fundindo sua unidade de pesquisa de IA, o Google Brain, com o DeepMind, o laboratório de pesquisa de IA da Alphabet em Londres. Portanto, o Google teve todo o ano para desenvolver sua resposta ao modelo de linguagem grande mais avançado da OpenAI, o GPT-4, que foi lançado em março e é a espinha dorsal da versão paga do ChatGPT.

O Google tem estado sob intensa pressão para mostrar aos investidores que pode igualar e superar os concorrentes em IA. Embora a empresa esteja desenvolvendo e usando modelos poderosos de Inteligência Artificial há anos, ela tem hesitado em lançar ferramentas com as quais o público possa brincar por medo de danos à reputação e preocupações com a segurança.

“O Google tem sido muito cauteloso ao liberar esse material para o público”, disse Geoffrey Hinton à MIT Technology Review em abril, quando deixou a empresa. “Há muitas coisas ruins que poderiam acontecer, e o Google não queria arruinar sua reputação.” Diante de tecnologias que pareciam não confiáveis ou não comercializáveis, o Google jogou pelo seguro – até que o maior risco passou a ser o de perder a oportunidade.

O Google aprendeu da maneira mais difícil como o lançamento de produtos com falhas pode ser um tiro pela culatra. Quando revelou o Bard, concorrente do ChatGPT em fevereiro, os cientistas logo notaram um erro factual no anúncio da própria empresa para o chatbot, um incidente que, posteriormente, eliminou US$ 100 bilhões do preço de suas ações.

Em maio, o Google anunciou que estava implementando a IA generativa na maioria de seus produtos, de e-mail a software de produtividade. Mas os resultados não impressionaram os críticos: o chatbot fez referências a e-mails que não existiam, por exemplo.

Esse é um problema constante com modelos de linguagem grandes. Embora sejam excelentes na geração de texto que soa como algo que um ser humano poderia ter escrito, os sistemas de IA generativa regularmente inventam coisas. E esse não é o único problema com eles. Eles também são fáceis de hackear e repletos de vieses. Seu uso também é altamente poluente.

O Google não resolveu nem esses problemas nem a questão da alucinação. Sua solução para esse último problema é uma ferramenta que permite que as pessoas usem a pesquisa do Google para verificar as respostas do chatbot, mas que depende da precisão dos próprios resultados da pesquisa on-line.

O Gemini pode ser o auge dessa onda de IA generativa. Mas não está claro qual será o próximo passo da IA baseada em grandes modelos de linguagem. Alguns pesquisadores acreditam que esse pode ser um platô, e não o pé do próximo pico.

Pichai não se deixa abater. “Olhando para o futuro, vemos muito espaço livre”, diz ele. “Acho que a multimodalidade será importante. À medida que ensinarmos esses modelos a raciocinar mais, haverá avanços cada vez maiores. Avanços mais profundos ainda estão por vir.

“Quando vejo tudo isso, realmente sinto que estamos no começo.”

Mat Honan contribuiu com sua reportagem.