Em 20 de outubro, Francesca Mani foi chamada à sala do orientador em sua escola de ensino médio em Nova Jersey. Com 14 anos, estudante do segundo ano e esgrimista competitiva, Francesca não gostava de se meter em problemas. Naquele dia, um boato estava circulando pelos corredores: durante o verão, os meninos da escola haviam usado Inteligência Artificial para criar fotos sexualmente explícitas e até mesmo pornográficas de alguns de seus colegas. Ela ficou sabendo que era uma das mais de 30 meninas que poderiam ter sido vítimas. (Em um e-mail, a escola afirmou que “muito menos” do que 30 alunos foram afetados).

Francesca não viu a foto de si mesma naquele dia. E ela ainda não pretende ver. Em vez disso, está dedicando toda a sua energia para garantir que ninguém mais seja alvo dessa forma.

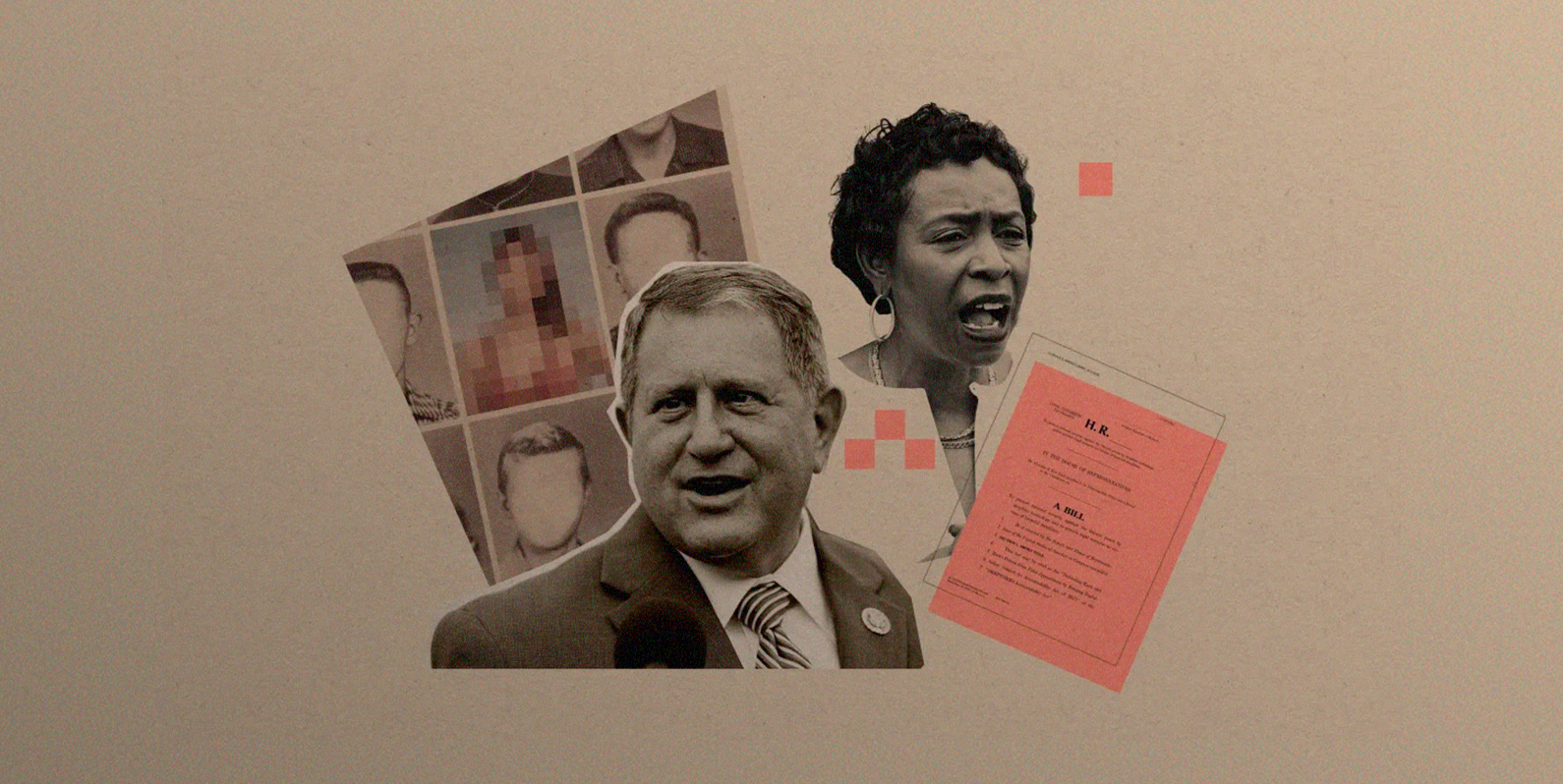

24 horas após tomar conhecimento das fotos, Francesca estava escrevendo cartas para quatro legisladores da região, compartilhando sua história e pedindo que tomassem providências. Três deles responderam rapidamente: o representante dos EUA Joe Morelle, de Nova York, o representante dos EUA Tom Kean Jr., de Nova Jersey, e o senador estadual de Nova Jersey Jon Bramnick. Nas últimas semanas, sua defesa já alimentou um novo impulso legislativo para regulamentar a pornografia deepfake não consensual nos EUA.

“Naquele dia, percebi que precisava me manifestar, porque realmente acho que isso não está certo”, disse-me Francesca em uma ligação telefônica esta semana. “Essa é uma tecnologia tão nova que as pessoas não conhecem e não sabem como se proteger dela.” Nas últimas semanas, além de comemorar seu 15º aniversário, Francesca lançou um novo site que oferece recursos para outras vítimas de pornografia deepfake.

Estudos realizados em 2019 e 2021 mostram que os deepfakes — que são imagens manipuladas de forma convincente pela IA geralmente trocando rostos ou vozes de diferentes mídias —‚ são usados principalmente para pornografia, na maioria das vezes sem o consentimento das pessoas que aparecem nas imagens. Além do consentimento, as deepfakes geraram sérias preocupações com a privacidade das pessoas online.

Como as ferramentas de IA continuaram a se proliferar e a se tornar mais populares no último ano, o mesmo aconteceu com a pornografia deepfake e o assédio sexual na forma de imagens geradas por IA. Em setembro, por exemplo, cerca de 20 meninas na Espanha receberam imagens de si mesmas nuas depois que a IA foi usada para tirar suas roupas em fotos. E em dezembro, uma de minhas colegas, a repórter Melissa Heikkilä, mostrou como o aplicativo viral de IA geradora Lensa criou representações sexualizadas dela sem seu consentimento — um contraste gritante com as imagens que produziu de nossos colegas homens.

Os esforços dos membros do Congresso para reprimir a pornografia deepfake não são totalmente novos. Em 2019 e 2021, a deputada Yvette Clarke apresentou o DEEPFAKES Accountability Act, que exige que os criadores de deepfakes coloquem marcas d’água em seu conteúdo. E em dezembro de 2022, o deputado Morelle, que agora está trabalhando em estreita colaboração com Francesca, apresentou o Preventing Deepfakes of Intimate Images Act. Seu projeto de lei se concentra em criminalizar a criação e a distribuição de deepfakes pornográficos sem o consentimento da pessoa cuja imagem é usada. Ambas as iniciativas, que não tiveram apoio bipartidário, foram paralisadas no passado.

Mas recentemente a questão atingiu um “ponto de inflexão”, diz Hany Farid, professor da Universidade da Califórnia, em Berkeley, porque a IA se tornou muito mais sofisticada, tornando o potencial de danos muito mais sério. “O vetor de ameaça mudou radicalmente”, diz Farid. Há cinco anos, a criação de um deepfake convincente exigia centenas de imagens, diz ele, o que significava que as pessoas com maior risco de serem alvos eram celebridades e pessoas famosas com muitas fotos acessíveis ao público. Mas agora os deepfakes podem ser criados com apenas uma imagem.

Farid diz: “acabamos de dar aos meninos do ensino médio a mãe de todas as armas nucleares para eles, que é poder criar pornografia com [uma única imagem] de quem eles quiserem. E, é claro, eles estão fazendo isso”.

Clarke e Morelle, ambos democratas de Nova York, reapresentaram seus projetos de lei este ano. O de Morelle agora tem 18 copatrocinadores de ambos os partidos, quatro dos quais aderiram depois que o incidente envolvendo Francesca veio à tona, o que indica que pode haver um impulso legislativo real para que o projeto seja aprovado. Ainda nesta semana, o deputado Kean, um dos copatrocinadores do projeto de lei de Morelle, lançou uma proposta relacionada para impulsionar os esforços de rotulagem de IA, em parte em resposta aos apelos de Francesca.

A regulamentação da IA nos EUA é uma questão complicada, embora o interesse em tomar medidas tenha atingido novos patamares (e alguns estados estejam avançando com suas próprias tentativas legislativas). As propostas de regulamentação de deepfakes geralmente incluem medidas para rotular e detectar conteúdo gerado por IA e moderar o material de abuso sexual infantil nas plataformas. Isso levanta questões políticas espinhosas e preocupações com a Primeira Emenda.

Morelle, no entanto, acredita que seu projeto de lei encontrou uma solução “elegante” que contorna algumas dessas questões, concentrando-se especificamente nos criadores e distribuidores — desenvolvendo um caminho para acusações civis e criminais e designando a criação e o compartilhamento de deepfakes pornográficos não consensuais como um crime federal. O projeto de lei “coloca realmente a responsabilidade e a exposição sobre a pessoa que publica algo sem o consentimento da pessoa que está na imagem ou no vídeo”, diz Morelle. O projeto de lei está sendo analisado pelo Comitê Judiciário da Câmara, e o escritório de Morelle planeja pressionar fortemente pela aprovação em janeiro. Se for aprovado no comitê, ele será votado no plenário da Câmara.

Farid diz que o projeto de lei de Morelle é um bom primeiro passo em direção à conscientização e à responsabilização, mas, a longo prazo, o problema precisará ser enfrentado a montante com os sites, serviços, empresas de cartão de crédito e provedores de serviços de Internet que estão “lucrando” com a pornografia deepfake não consensual.

Mas, enquanto isso, a falta de regulamentação e de precedentes legais sobre a pornografia deepfake significa que vítimas como Francesca têm pouco ou nenhum recurso. A polícia de Nova Jersey disse a Bramnick que o incidente provavelmente não passaria de uma “reclamação de assédio cibernético”, em vez de um crime mais sério, como pornografia infantil. Depois que Bramnick entrou em contato com Francesca, ele se juntou a ela como copatrocinador de um projeto de lei em Nova Jersey que instituiria penalidades civis e criminais para pornografia deepfake não consensual ao nível estadual.

A sensação de impotência é exatamente o que Francesca espera mudar. Ela e sua mãe, Dorota Mani, estão planejando ir a Washington, DC, nas próximas semanas para falar com membros do Congresso a fim de chamar mais atenção para a questão e pedir que aprovem o projeto de lei de Morelle.

“Deveríamos criar leis imediatamente para que, quando isso acontecer com você, você tenha uma lei para protegê-lo”, disse-me Francesca. “Eu realmente não tinha uma lei para me proteger.”