Há uma complexidade inerente à disseminação das deep fakes, pois estas não são apenas fruto da tecnologia, mas sim do engenho humano por trás de sua criação e propagação. Enquanto a sociedade está imersa em discussões sobre os severos impactos do uso indevido da Inteligência Artificial, é crucial reconhecer que tanto a resposta legislativa quanto as pesquisas em busca de ferramentas de detecção são reações necessárias a essa ameaça emergente.

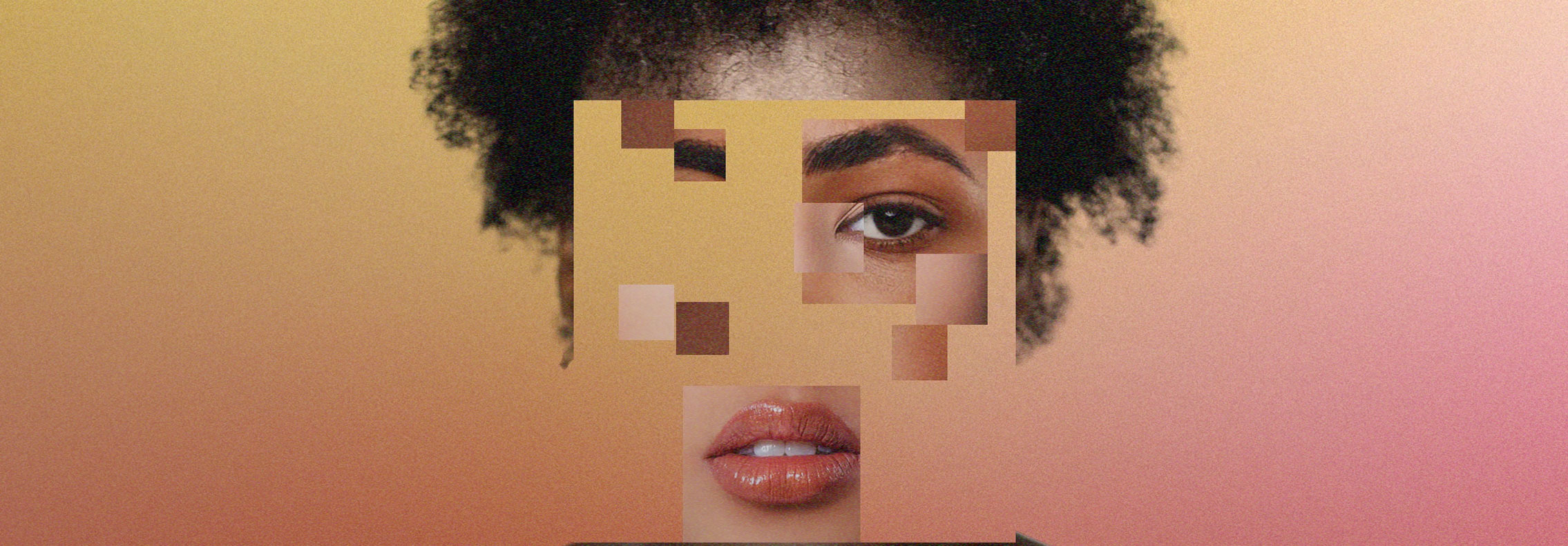

Em meio a corrida para combater os danos das deep fakes, é preocupante notar a escassez de debate em torno da justiça dos dados utilizados para treinar tais ferramentas. Este silêncio evidencia uma falha em considerar os possíveis vieses nos conjuntos de dados, o que pode comprometer a eficácia e a equidade das soluções propostas. Há uma observação perspicaz de que a intensa atenção dada à mitigação dos efeitos negativos das deep fakes pode, paradoxalmente, obscurecer questões essenciais, como a ética por trás de seu desenvolvimento e disseminação. Esse direcionamento seletivo pode ser interpretado como uma estratégia para desviar a atenção de detalhes cruciais.

É amplamente reconhecido por pesquisadores negros e ativistas que o histórico dos dados desempenha um papel fundamental na compreensão e na mitigação dos vieses presentes nos conjuntos de dados utilizados em diversas aplicações de Inteligência Artificial. Pesquisadores como Joy Buolamwini, do Instituto de Tecnologia de Massachusetts (MIT), e Timnit Gebru, do DAIR Institute , têm ressaltado repetidamente a importância de examinar criticamente a origem e o contexto dos dados para garantir a justiça e a equidade nas soluções de IA. Esses pesquisadores destacam que os conjuntos de dados muitas vezes refletem e perpetuam as desigualdades sociais existentes, incluindo vieses de raça, gênero e classe. Como resultado, o uso desses conjuntos de dados pode levar a sistemas que discriminam ou marginalizam certos grupos, exacerbando assim as injustiças existentes na sociedade.

Esta percepção é evidenciada no livro “Misogynoir transformada”, no qual a autora Moyla Bailey destaca como as mulheres negras resistiram à cultura antinegra gerada em plataformas online. A autora ressalta como a imagem dessas mulheres foi distorcida, contribuindo para a violência diária e a memorização dessa violência. Fazendo um paralelo com a tecnologia por trás das deep fakes, que depende da coleta de dados, muitas vezes sem permissão, de imagens da internet e redes sociais para o treinamento das ferramentas, surge a preocupação sobre o impacto e os danos da memorização dessa violência por meio destas técnicas.

É fundamental abordar essas questões de forma holística para mitigar os efeitos negativos que vão além da desinformação. Em 2019, o FaceApp, um aplicativo de edição de fotos que permite aos usuários alterarem sua aparência de várias maneiras, tornou-se viral em todo o mundo. No entanto, logo surgiram preocupações sobre a privacidade dos dados dos usuários e os vieses presentes nas funcionalidades do aplicativo. Uma das funcionalidades mais populares do FaceApp permitia aos usuários alterar sua aparência para parecerem mais jovens ou mais velhos. No entanto, muitos relataram que o algoritmo do aplicativo tinha uma tendência a suavizar a pele e afinar os traços faciais de pessoas brancas, enquanto tornava os traços de pessoas negras mais exagerados e caricatos. Isso levantou preocupações sobre vieses raciais presentes nos algoritmos de IA usados pelo aplicativo. Essa discrepância na maneira como o FaceApp manipulava imagens de pessoas de diferentes raças destacou como os vieses nos dados utilizados para treinar esses algoritmos podem influenciar a percepção pública.

É crucial analisar com cuidado exemplos como esse e categorizá-los corretamente em relação aos problemas que representam. Afinal, pela literatura, o app não é considerado aplicativo de deep fake, porém, a problemática da memorização da violência por meio de técnicas de manipulação de mídia não se limita apenas à simplicidade com que estão definindo o que é deep fake. Isso me leva a questionar o que exatamente define uma manipulação como deep fake. Devemos nos basear nas técnicas de manipulação e edição em si ou nos resultados que têm impacto na opinião pública? Essa reflexão destaca a necessidade de visão mais holística para as definições que podem basear as deep fakes pois ela pode ser pensada para diferentes cenários e isso demanda uma compreensão mais profunda de suas implicações.

—–