A IA levou a avanços em descoberta de medicamentos e robótica e está transformando a forma com que interagimos com máquinas e com a web. Mas há um problema: não sabemos exatamente como ela funciona ou por que funciona tão bem. Temos uma ideia geral, mas os detalhes são complexos demais para desvendar. Isso é preocupante, pois pode nos levar a usar sistemas de IA em áreas sensíveis, como a medicina, sem saber se eles têm falhas críticas embutidas.

Uma equipe do Google DeepMind que estuda a “interpretabilidade mecanicista” tem trabalhado em novas formas de examinar o que ocorre internamente na IA. Em julho, eles lançaram a Gemma Scope, uma ferramenta para ajudar pesquisadores a entender o que acontece quando a IA gera uma saída. A esperança é que, ao compreender melhor o que ocorre dentro de um modelo de IA, possamos controlar suas saídas de forma mais eficaz, levando a sistemas de IA mais confiáveis.

“Quero poder olhar dentro de um modelo e ver se ele está sendo enganoso”, diz Neel Nanda, chefe da equipe de interpretabilidade mecanicista no Google DeepMind. “Parece que poder ler a ‘mente’ de um modelo pode ajudar.”, afirma.

A interpretabilidade mecanicista, ou “mech interp”, é um campo novo de pesquisa que busca entender como as redes neurais realmente funcionam. De maneira muito básica, inserimos dados em um modelo e obtemos pesos no final do treinamento, ou seja, os parâmetros que determinam como o modelo toma decisões. Sabemos que a IA encontra padrões e tira conclusões desses padrões, mas esses padrões são incrivelmente complexos e difíceis para humanos interpretarem.

É como um professor corrigindo uma questão complexa de matemática: o “aluno” — no caso, a IA — acertou o resultado, mas o trabalho é uma série de linhas confusas. Neste exemplo, assume-se que a IA sempre dá a resposta correta, mas nem sempre é o caso; ela pode ter identificado um padrão irrelevante e o tratado como válido. Por exemplo, alguns sistemas de IA atuais podem dizer que 9,11 é maior que 9,8. Diferentes métodos desenvolvidos na área de interpretabilidade mecanicista estão começando a dar sentido a esses “rabiscos”.

“Um dos objetivos principais da interpretabilidade mecanicista é tentar fazer a engenharia reversa dos algoritmos desses sistemas”, diz Nanda. “Nós damos um comando, como ‘Escreva um poema’, e a IA escreve versos rimados. Qual é o algoritmo que a levou a isso? Adoraríamos entender.”

Para encontrar recursos ou categorias de dados que representem conceitos maiores em seu modelo Gemma, o DeepMind usou uma ferramenta conhecida como “autoencoder esparso” em cada uma das camadas do modelo. Imagine o autoencoder esparso como um microscópio que permite observar os detalhes dessas camadas. Por exemplo, ao pedir à Gemma informações sobre um chihuahua, a ferramenta ativa o recurso “cães”, acessando tudo o que o modelo sabe sobre “cães”. Ele é considerado “esparso” por limitar o número de neurônios usados, buscando uma representação mais eficiente e generalizada dos dados.

O desafio dos autoencoders esparsos é escolher o nível de detalhe. Pense novamente no microscópio: você pode ampliar algo a um nível extremo, mas isso pode tornar o que vê ininterpretável para um humano. Por outro lado, se ampliar pouco, pode perder detalhes interessantes.

A solução do DeepMind foi usar autoencoders esparsos de tamanhos diferentes, variando o número de recursos que desejam identificar. O objetivo não era que os pesquisadores do DeepMind analisassem completamente os resultados sozinhos. A Gemma e os autoencoders são de código aberto, incentivando pesquisadores interessados a explorarem os achados e, com sorte, descobrirem novas lógicas internas do modelo. Como o DeepMind usou autoencoders em cada camada de seu modelo, um pesquisador poderia mapear o progresso dos dados de entrada para a saída de uma maneira inédita.

“Isso é realmente empolgante para pesquisadores de interpretabilidade”, diz Josh Batson, pesquisador da Anthropic. “Com este modelo de código aberto para estudo, uma série de pesquisas de interpretabilidade pode agora ser feita a partir desses autoencoders esparsos, facilitando o aprendizado e a análise desses métodos.”

Em julho, a Neuronpedia, plataforma de interpretabilidade mecanicista, fez parceria com o DeepMind para criar uma demonstração do Gemma Scope, acessível para testes. Nela, é possível testar diferentes comandos e ver como o modelo divide o comando e quais ativações ele ilumina. Você também pode explorar o modelo: por exemplo, ao aumentar bastante a configuração sobre “cães” e, em seguida, fazer uma pergunta sobre presidentes dos EUA, a Gemma pode acabar incluindo referências aleatórias a cães, ou até mesmo começar a “latir”.

Uma característica interessante dos autoencoders esparsos é que eles são não supervisionados, ou seja, identificam recursos sozinhos, o que leva a descobertas surpreendentes de como o modelo interpreta conceitos humanos. “Meu recurso favorito é o recurso ‘cringe’”, diz Joseph Bloom, líder científico da Neuronpedia. “Ele aparece em críticas negativas de textos e filmes. É um ótimo exemplo de algo que ressoa em um nível humano.”

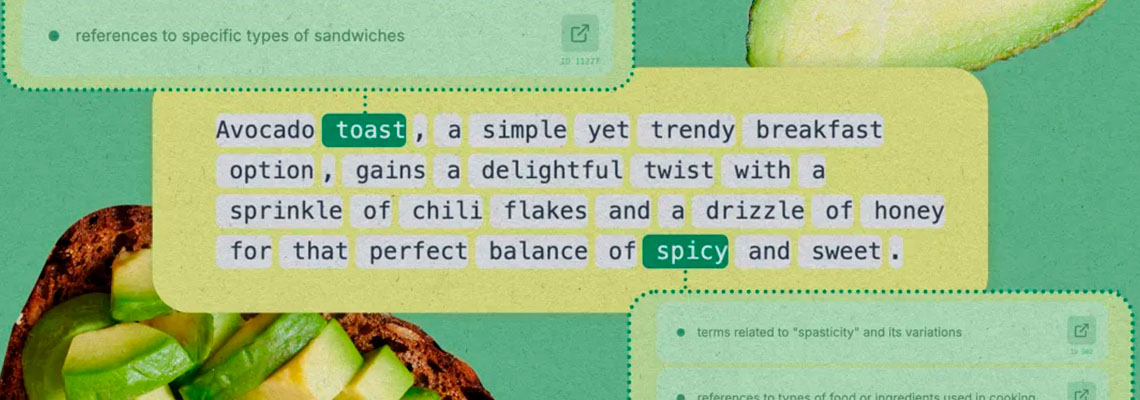

Você pode buscar conceitos na Neuronpedia, que destaca os recursos ativados em tokens específicos e a intensidade de cada ativação. “Se você lê o texto e vê algo destacado em verde, é quando o modelo acha que o conceito de ‘cringe’ é mais relevante. O exemplo mais ativo é alguém pregando para outra pessoa”, explica Bloom.

Alguns recursos estão se mostrando mais fáceis de rastrear do que outros. “Um dos recursos mais importantes que você gostaria de encontrar em um modelo é a ‘decepção’”, diz Johnny Lin, fundador da Neuronpedia. “Mas não é fácil localizar algo que dispare quando a IA está mentindo. Pelo que vimos, ainda não é possível encontrar e banir a decepção.”

A pesquisa do DeepMind é semelhante ao que a Anthropic fez em maio com o Golden Gate Claude. Usaram autoencoders esparsos para identificar as partes de Claude, seu modelo, que eram ativadas ao falar sobre a ponte Golden Gate, em São Francisco. Então, amplificaram essas ativações até o ponto em que Claude literalmente se identificava não como Claude, mas como a própria Ponte Golden Gate, respondendo aos comandos como se fosse a ponte.

Embora isso possa parecer curioso, a pesquisa em interpretabilidade mecanicista tem um potencial incrível. “Como ferramenta para entender como o modelo generaliza e em que nível de abstração opera, esses recursos são muito úteis”, diz Batson.

Por exemplo, uma equipe liderada por Samuel Marks, agora na Anthropic, usou autoencoders esparsos para encontrar recursos que mostravam que um modelo associava certas profissões a um gênero específico. Eles então desativaram esses recursos para reduzir o viés do modelo. Esse experimento foi realizado em um modelo pequeno, então não está claro se o trabalho será aplicável a modelos muito maiores.

A pesquisa de interpretabilidade mecanicista também pode dar insights sobre erros de IA. No caso do erro de afirmar que 9,11 é maior que 9,8, pesquisadores da Transluce viram que a pergunta estava ativando partes do modelo associadas a versículos bíblicos e a 11 de setembro. Concluíram que a IA poderia estar interpretando os números como datas, considerando 9/11 como maior que 9/8. Em muitos livros, como textos religiosos, a seção 9.11 vem depois da 9.8, o que pode explicar por que a IA “achava” que 9,11 era maior. Uma vez que entenderam o erro, os pesquisadores reduziram as ativações da IA para versículos bíblicos e setembro de 11, o que levou o modelo a responder corretamente se 9,11 era maior que 9,8.

Há outras aplicações potenciais. Atualmente, LLMs incluem comandos internos para lidar com perguntas sensíveis , a exemplo de “como fazer uma bomba”. Quando você pergunta ao ChatGPT, ele é secretamente instruído pela OpenAI a não fornecer informações perigosas. Porém, usuários conseguem contornar esses bloqueios com prompts inteligentes.

Se os criadores dos modelos conseguissem identificar onde estão esses “nós” de informação, poderiam desligá-los permanentemente, evitando respostas sobre como fazer uma bomba. Essa granularidade e controle preciso são imagináveis, mas extremamente difíceis de alcançar com a interpretabilidade mecanicista atual.

“Uma limitação é que a ‘direção’ (ajustes nos parâmetros do modelo) ainda não funciona muito bem. Se você tenta reduzir a violência no modelo, pode acabar reduzindo também seu conhecimento em artes marciais”, diz Lin. O conhecimento sobre “fabricação de bombas”, por exemplo, não é um simples interruptor dentro de um modelo de IA; provavelmente está distribuído em várias partes, e desligá-lo pode afetar o conhecimento de química da IA. Ajustes podem trazer benefícios, mas também grandes concessões.

Ainda assim, se conseguirmos explorar mais a “mente” da IA, o Google DeepMind e outros acreditam que a interpretabilidade mecanicista pode ser um caminho viável para o alinhamento — o processo de garantir que a IA faça exatamente o que queremos.