O mercado de Inteligência Artificial vive uma corrida bilionária que está redefinindo a infraestrutura tecnológica global. No centro dessa disputa estão duas gigantes: Nvidia, líder absoluta com suas GPUs (Unidades de Processamento Gráfico), e Alphabet, que avança com suas TPUs (Unidades de Processamento de Tensores). Essa batalha não é apenas sobre quem tem o chip mais rápido. Ela pode alterar margens, estratégias e até, principalmente, o valor de mercado das empresas envolvidas, com reflexos diretos para todo o ecossistema de IA.

Para contextualizar, vale entender as diferenças técnicas entre as duas soluções. As GPUs da Nvidia foram originalmente projetadas para processamento gráfico, mas evoluíram para executar cálculos paralelos em larga escala, tornando-se ideais para aplicações diversas, incluindo a IA, simulações científicas e renderização. Elas oferecem alta flexibilidade, suportando frameworks como CUDA, PyTorch e TensorFlow, além de memória robusta (até 141 GB, nas H200) e interconexões NVLink para clusters massivos.

Já as TPUs da Alphabet são ASICs (Application-Specific Integrated Circuits) desenvolvidos para otimizar operações de tensor, núcleo das redes neurais profundas. Essa especialização garante maior eficiência energética e desempenho superior em cargas específicas, como treinamento de grandes modelos de linguagem (LLMs, ou Large Language Models, em inglês), com até quatro vezes melhor performance por dólar em comparação às GPUs em cenários de grande escala, segundo dados da Google. No entanto, as TPUs são menos versáteis, operando principalmente em ambientes Google Cloud e integradas a frameworks como TensorFlow e JAX.

Atualmente, a Nvidia é praticamente sinônimo de chip para IA. Com cerca de 90% de participação no mercado de GPUs voltadas para Inteligência Artificial, a empresa transformou sua linha de chips em um dos pilares da computação moderna. Em 2025, reportou números impressionantes: US$ 57 bilhões em receita trimestral e lucro líquido de quase US$ 32 bilhões, um salto de 65% em relação ao ano anterior. O segmento de data centers, que concentra as vendas para IA, respondeu por mais de US$ 51 bilhões nesse período, impulsionado pela demanda crescente por modelos generativos e LLMs. Esse desempenho fez da Nvidia a empresa mais valiosa do mundo, com valor de mercado acima de US$ 5 trilhões. Mas tamanha dependência das GPUs cria vulnerabilidades: gargalos na cadeia de suprimentos, pressão sobre preços e riscos regulatórios.

É nesse contexto que a Alphabet decidiu entrar no jogo com força. A empresa investe há mais de uma década em TPUs, inicialmente usadas internamente e oferecidas via Google Cloud. Agora, a estratégia mudou: negocia instalar TPUs diretamente nos data centers da Meta a partir de 2027, além de oferecer aluguel via nuvem já em 2026. Esse movimento valida a tecnologia fora do ecossistema Google, amplia escala e reforça a integração vertical da empresa, que controla hardware, software e serviços de nuvem.

A Alphabet já fechou um acordo para fornecer até um milhão de TPUs à Anthropic, uma das startups mais promissoras do setor, e promete entregar maior eficiência energética e melhor performance por dólar em cargas específicas, o que é fator crítico para reduzir custos operacionais.

O impacto financeiro potencial pode ser grande. Analistas estimam que, se a estratégia da Alphabet avançar, ela pode capturar até 10% da receita anual da Nvidia em curto prazo, um mercado que vale dezenas de bilhões de dólares. Essa projeção se sustenta nos números atuais: a Nvidia faturou US$ 130,5 bilhões em 2025, sendo US$ 35,6 bilhões apenas no segmento de data centers.

Segundo Morgan Stanley, cada 500 mil TPUs vendidas pode adicionar US$ 13 bilhões à receita da Alphabet, e acordos como o negociado com a Meta podem acelerar essa captura de mercado. Para a Alphabet, o efeito vai além da venda de chips: a expansão das TPUs fortalece o Google Cloud, que já é um dos pilares de crescimento da empresa. Com receita consolidada de mais de US$ 102 bilhões por trimestre, em 2025, a Alphabet tem fôlego para subsidiar preços agressivos e ganhar participação rapidamente.

Com as primeiras notícias dessa disputa, o mercado reagiu de forma imediata. Quando surgiram rumores sobre negociações entre Google e Meta, as ações da Nvidia caíram quase 7%, enquanto os papéis da Alphabet subiram mais de 3% em um único dia. Esse movimento mostra que investidores já precificam a possibilidade de uma mudança estrutural no setor. Além disso, a diversificação de fornecedores é bem-vinda para big techs como Meta, Amazon e Microsoft, que enfrentam escassez de GPUs e custos crescentes. A competição tende a reduzir preços, acelerar inovação e ampliar a oferta de infraestrutura, um ganho líquido para todo o mercado.

A competição entre Nvidia e Alphabet não impacta apenas preços e participação de mercado, mas também pode redefinir o ecossistema de inovação e trazer implicações diretas para o setor de energia. A corrida por chips mais eficientes força avanços em arquiteturas que reduzem consumo de energia, um fator crítico diante do crescimento exponencial da IA. Treinar um único modelo de linguagem de grande porte pode demandar megawatts de potência, elevando custos e pressionando metas de sustentabilidade corporativa.

Nesse cenário, TPUs da Alphabet, com melhor performance por watt em cargas específicas, e GPUs da Nvidia, que evoluem para tecnologias como HBM3e e interconexões otimizadas, representam não apenas ganhos de velocidade, mas também uma resposta à urgência por eficiência energética. Também é esperada uma aceleração de investimentos em pesquisa, fomentando soluções para data centers verdes, e pode influenciar políticas de descarbonização, tornando a inovação em chips um vetor estratégico para equilibrar crescimento tecnológico e responsabilidade ambiental.

Devemos lembrar que outros players também se posicionam para capturar parte desse mercado bilionário. A AMD surge como concorrente direta com sua linha Instinct MI300X, que oferece até 192 GB de memória HBM3 e largura de banda superior a 5 TB/s, prometendo desempenho até 40% melhor em algumas cargas de LLMs em relação ao H100 da Nvidia, além de custo competitivo. A Amazon aposta em seus chips próprios, Trainium, para treinamento, e Inferentia, para inferência, integrados à AWS, oferecendo até 70% de redução no custo por inferência e já utilizados por clientes como Anthropic. A Microsoft também entrou na disputa com o Maia 100, seu primeiro acelerador de IA para Azure, e planeja lançar versões mais avançadas até 2027 para reduzir dependência da Nvidia.

A Intel lançou o Gaudi 3, com foco em custo-benefício e arquitetura aberta, prometendo até 70% melhor relação preço/desempenho em inferência para modelos como Llama 3 80B. No mercado chinês, empresas como Baidu e Huawei desenvolvem chips próprios, como a linha Kunlun da Baidu, que já recebeu pedidos superiores a US$ 140 milhões e pode atingir US$ 1,1 bilhão em vendas até 2026. Essa diversificação indica que o domínio da Nvidia será desafiado por uma combinação de soluções customizadas, preços agressivos e integração vertical, criando um cenário de competição intensa e inovação acelerada.

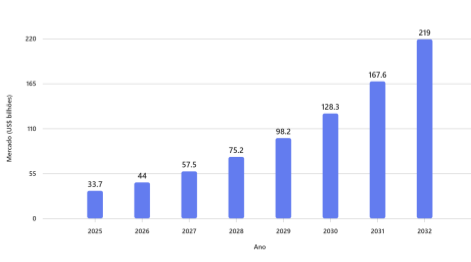

As projeções para os próximos anos são ambiciosas. O mercado global de aceleradores de IA deve saltar de US$ 33,7 bilhões em 2025 para mais de US$ 219 bilhões em 2032, com crescimento anual superior a 30%, segundo dados da Bloomberg Intelligence. Nesse cenário, cada ponto percentual de participação representa bilhões de dólares em receita.

A Nvidia tende a continuar dominante em ambientes multi-cloud e aplicações gerais, mas pode ver suas margens comprimidas. Já a Alphabet deve consolidar um nicho premium, integrado ao seu stack de IA, com potencial para capturar contratos bilionários em setores regulados como finanças, saúde e governo.

Gráfico: Projeção do Mercado Global de Aceleradores de IA (2025-2032)

Fonte: Bloomberg Intelligence

No fim das contas, quem ganha com essa guerra? O mercado. Empresas de tecnologia terão alternativas para reduzir custos e evitar dependência de um único fornecedor. O mercado financeiro verá maior competição, equilibrando valuations e reduzindo riscos de concentração. E consumidores e startups terão acesso a infraestrutura mais barata e escalável, acelerando a democratização da IA.

Quem acha que a disputa entre Alphabet e Nvidia é apenas uma guerra de chips está bastante enganado. Essa é uma batalha pelo controle do stack de Inteligência Artificial. Enquanto a Nvidia aposta na flexibilidade e no ecossistema CUDA, a Alphabet investe em integração vertical e eficiência. Para investidores, isso significa acompanhar não só quem vende mais chips, mas quem captura mais valor ao longo da cadeia. Se a Alphabet conseguir converter sua vantagem tecnológica em contratos de grande escala, o mercado pode assistir à primeira grande redistribuição de poder na infraestrutura de IA desde o boom das GPUs. E, para o ecossistema, essa competição é saudável: mais inovação, mais opções e, no longo prazo, um potencial maior de crescimento.