Com a GPT-3, a OpenAI mostrou que um único modelo de deep learning pode ser treinado para usar a linguagem de várias maneiras, desde que recebesse grandes quantidades de texto. Então, mostrou que, trocando texto por pixels, a mesma abordagem poderia ser usada para treinar uma IA para completar imagens inacabadas. O GPT-3 imita como os humanos usam as palavras; O GPT-3 com imagens prevê o que vemos.

Agora, a OpenAI juntou essas ideias e construiu dois novos modelos, chamados DALL·E e CLIP, que combinam linguagem e imagens de uma forma que irá melhorar a compreensão que as IAs têm, tanto das palavras, quanto daquilo a que se referem.

“Vivemos em um mundo visual”, diz Ilya Sutskever, cientista-chefe da OpenAI. “No futuro, teremos modelos que entendem tanto texto como imagens. A IA será capaz de entender melhor a linguagem pois poderá ver o que as palavras e frases significam”.

Apesar de todo o talento do GPT-3, seus resultados podem parecer desconectados da realidade, como se não soubesse do que está falando. E realmente não sabe. Ao basear texto em imagens, os pesquisadores da OpenAI e de outros lugares estão tentando dar aos modelos de linguagem uma melhor compreensão dos conceitos cotidianos que os humanos usam para dar sentido às coisas.

O DALL·E e o CLIP abordam esse problema por diferentes ângulos. À primeira vista, o CLIP (Contrastive Language-Image Pre-Training, ou “Pré-treinamento Contrastivo Linguagem-imagem”, em tradução livre) é mais um sistema de reconhecimento de imagem. A diferença é que aprendeu a reconhecer imagens não de exemplos rotulados em conjuntos de dados selecionados, como a maioria dos modelos existentes, mas de imagens e suas legendas retiradas da Internet. Ele aprende o que está em uma imagem a partir de uma descrição, em vez de um rótulo de uma palavra só, como “gato” ou “banana”.

O CLIP é treinado para prever qual legenda de uma seleção aleatória de 32.768 é a correta para uma determinada imagem. Para resolver isso, o CLIP aprende a ligar uma grande variedade de objetos aos seus nomes e às palavras que os descrevem. Isso permite que ele identifique objetos em imagens fora de seu conjunto de treinamento. A maioria dos sistemas de reconhecimento de imagem são treinados para identificar certos tipos de objetos, como rostos em vídeos de vigilância ou edifícios em imagens de satélite. Assim como o GPT-3, o CLIP pode generalizar as tarefas sem treinamento adicional. Em comparação com outros modelos de reconhecimento de imagem de última geração, o CLIP também tem menor probabilidade de ser confundido por imagens contraditórias, que foram sutilmente alterados de maneiras que normalmente confundem algoritmos, embora os humanos possam não notar a diferença.

Em vez de reconhecer imagens, o DALL·E (que acredito ser um trocadilho com WALL·E / Dali) as desenha. Este modelo é uma versão menor do GPT-3 que também foi treinado com pares texto-imagem obtidos da Internet. Com uma pequena legenda em linguagem natural, como “uma pintura de uma capivara sentada em um campo ao nascer do sol” ou “um corte transversal de uma noz”, o DALL·E gera muitas imagens que correspondem a ela: dezenas de capivaras de todas as formas e tamanhos com fundos laranjas e amarelos; várias fileiras de nozes (embora nem todas com corte transversal).

Resultados surreais

Os resultados são impressionantes, embora ainda não sejam sempre bons. A legenda “um vitral com a imagem de um morango azul” produz muitos resultados corretos, mas também alguns que têm janelas azuis e morangos vermelhos. Outros não contêm nada que se pareça com uma janela ou um morango. Os resultados apresentados pela equipe da OpenAI em uma postagem no seu blog não foram escolhidos a dedo, mas classificados pelo CLIP, que selecionou as 32 imagens do DALL·E que considera melhor corresponder à descrição de cada legenda.

“A síntese de texto para imagem é um desafio de pesquisa que já existe há algum tempo”, diz Mark Riedl, que trabalha com PLN e criatividade computacional no Instituto de Tecnologia da Geórgia, em Atlanta. “Mas estes exemplos são impressionantes”.

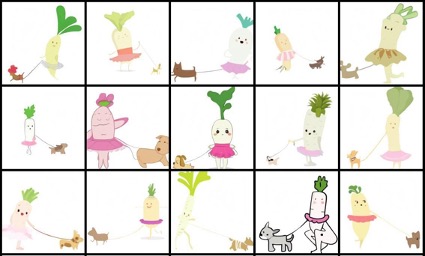

Imagens desenhadas pelo DALL·E para a legenda “Um bebê nabo vestindo um tutu passeando com um cachorro”

Para testar a capacidade do DALL·E de trabalhar com conceitos novos, os pesquisadores lhe deram legendas que descreviam objetos que achavam que ele não teria visto antes, como “uma poltrona de abacate” e “uma ilustração de um bebê nabo vestindo um tutu passeando com um cachorro”. Em ambos os casos, a IA gerou imagens que combinaram esses conceitos de maneiras plausíveis.

As poltronas, em particular, se parecem todas com cadeiras e abacates. “O que mais me surpreendeu é que o modelo pode pegar dois conceitos não relacionados e colocá-los juntos de uma forma que resulta em algo funcional”, diz Aditya Ramesh, que trabalhou no DALL·E. Isso provavelmente ocorre porque um abacate cortado ao meio se parece um pouco com uma poltrona de encosto alto, com o caroço como uma almofada. Para outras legendas, como “um caracol feito de harpa”, os resultados não são tão bons, com imagens que combinam caracóis e harpas de maneiras estranhas.

O DALL·E é o tipo de sistema que Riedl imaginou submeter ao teste Lovelace 2.0, um experimento de pensamento idealizado por ele em 2014. O teste tem como objetivo substituir o teste de Turing como referência para medir a inteligência artificial. Ele supõe que uma marca de inteligência é a capacidade de combinar conceitos de maneiras criativas. Riedl sugere que pedir a um computador para fazer um desenho de um homem segurando um pinguim é um teste de inteligência melhor do que pedir a um robô de conversação para se passar por um humano em uma conversa, porque é mais flexível e mais difícil de trapacear.

“O verdadeiro teste é ver até que ponto a IA pode ser levada para fora de sua zona de conforto”, diz Riedl.

Imagens desenhadas por DALL·E para a legenda “caracol feito de harpa”

“A capacidade do modelo de gerar imagens sintéticas a partir de textos excêntricos me parece muito interessante”, diz Ani Kembhavi, do Allen Institute for Artificial Intelligence (AI2), que também desenvolveu um sistema que gera imagens a partir de texto. “Os resultados parecem obedecer à semântica desejada, o que acho bastante impressionante.” Jaemin Cho, um colega de Kembhavi, também está impressionado: “Os geradores de texto para imagem existentes não mostraram este nível de controle desenhando vários objetos ou as habilidades de raciocínio espacial do DALL·E”, diz ele.

No entanto, DALL·E já mostra sinais de desgaste. Incluir muitos objetos em uma legenda prejudica sua capacidade de controlar o que desenha. E reformular uma legenda com palavras que significam a mesma coisa às vezes produz resultados diferentes. Também há sinais de que o DALL·E esteja imitando imagens que encontrou online, ao invés de gerar imagens novas.

“Eu suspeito um pouco do exemplo do nabo, que estilisticamente sugere que ele pode ter memorizado alguma arte da internet”, diz Riedl. Ele observa que uma pesquisa rápida traz muitas imagens cartunescas de nabos antropomorfizados. “O GPT-3, no qual o DALL·E se baseia, é famoso por memorizar”, diz ele.

Ainda assim, a maioria dos pesquisadores de IA concorda que ancorar a linguagem à compreensão visual é uma boa maneira de tornar as IAs mais inteligentes.

“O futuro consistirá em sistemas como este”, diz Sutskever. “E ambos os modelos são um passo em direção a esse sistema”.