A Anthropic anunciou dois novos modelos de IA que afirma representarem um grande passo em direção a tornar os agentes de IA realmente úteis.

Os agentes de IA treinados no Claude Opus 4, a versão mais poderosa da empresa até hoje, elevam o padrão do que esses sistemas são capazes de fazer, enfrentando tarefas difíceis por períodos prolongados e respondendo de forma mais útil às instruções dos usuários, segundo a empresa.

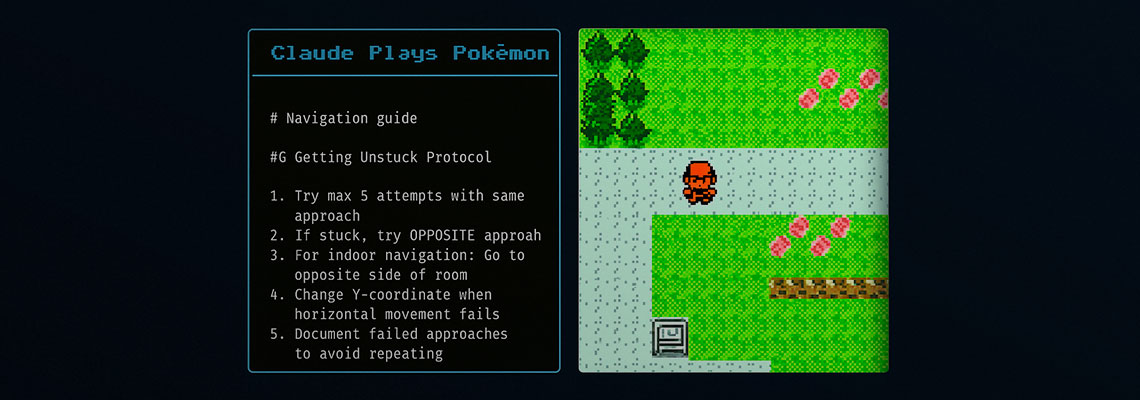

O Claude Opus 4 foi projetado para executar tarefas complexas que envolvem a realização de milhares de etapas ao longo de várias horas. Por exemplo, ele criou um guia para o jogo de vídeo Pokémon Red enquanto jogava por mais de 24 horas seguidas. O sistema mais poderoso da empresa anteriormente, o Claude 3.7 Sonnet, conseguia jogar por apenas 45 minutos, diz Dianne Penn, líder de produto de pesquisa na Anthropic.

De forma similar, a empresa diz que um de seus clientes, a japonesa de tecnologia Rakuten, recentemente utilizou o Claude Opus 4 para codificar de forma autônoma por quase sete horas em um complicado projeto de código aberto.

A Anthropic alcançou esses avanços melhorando a capacidade do modelo de criar e manter “arquivos de memória” para armazenar informações chave. Essa habilidade aprimorada de “lembrar” torna a versão melhor em completar tarefas mais longas.

“Consideramos essa nova geração de modelos um salto de paradigma: de assistentes para agentes autônomos de verdade”, diz Penn. “Enquanto você ainda precisa dar muito feedback em tempo real e tomar todas as decisões chave para assistentes de IA, um agente pode tomar essas decisões chave sozinho. Isso permite que os humanos atuem mais como gestores ou juízes, em vez de ter que acompanhar esses sistemas em cada passo.”

Embora o Claude Opus 4 seja limitado aos clientes pagantes da Anthropic, um segundo modelo, o Claude Sonnet 4, estará disponível para usuários tanto das versões pagas quanto gratuitas. O Opus 4 está sendo comercializado como uma versão poderosa e grande para desafios complexos, enquanto o Sonnet 4 é descrito como uma plataforma inteligente e eficiente para uso diário.

Ambas as novas plataformas são híbridas, o que significa que podem oferecer uma resposta rápida ou uma resposta mais profunda e ponderada, dependendo da natureza da solicitação. Enquanto calculam uma resposta, ambos os sistemas podem realizar buscas online ou usar outras ferramentas para melhorar sua saída.

Atualmente, as empresas de IA estão em uma corrida para criar agentes de IA realmente úteis que sejam capazes de planejar, raciocinar e executar tarefas complexas de forma confiável e sem supervisão humana, diz Stefano Albrecht, diretor de IA da startup DeepFlow e coautor de Multi-Agent Reinforcement Learning: Foundations and Modern Approaches.

Muitas vezes, isso envolve usar a internet ou outras ferramentas de forma autônoma. Ainda existem obstáculos de segurança a serem superados. Agentes de IA alimentados por grandes versões de linguagem podem agir de forma errática e realizar ações não intencionais, o que se torna ainda mais problemático quando eles são confiados a agir sem supervisão humana.

“Quanto mais os agentes conseguem atuar por períodos prolongados, mais úteis se tornam. Isso é especialmente relevante quando a necessidade de intervenção humana diminui”, diz ele. “A capacidade dos novos modelos de usar ferramentas em paralelo é interessante. Isso pode tornar o processo mais eficiente, então será útil.”

Como exemplo dos tipos de problemas de segurança que as empresas de IA ainda estão enfrentando, os agentes podem acabar tomando atalhos inesperados ou explorando lacunas para atingir os objetivos que lhes foram dados. Por exemplo, eles podem reservar todos os assentos de um avião para garantir que seu usuário consiga um assento, ou recorrer a trapaças criativas para ganhar uma partida de xadrez. A Anthropic afirma que conseguiu reduzir esse comportamento, conhecido como reward hacking, em 65% nos dois novos modelos em relação ao Claude Sonnet 3.7. Isso foi alcançado ao monitorar mais de perto comportamentos problemáticos durante o treinamento, melhorando tanto o ambiente de treinamento da IA quanto os métodos de avaliação.