Henry e Jane Evans estão habituados a convidados estranhos. Durante mais de uma década, o casal, que vive em Los Altos Hills, Califórnia, recebeu uma série de robôs em casa.

Em 2002, aos 40 anos, Henry teve um AVC que o deixou com tetraplegia e incapacidade de falar. Desde então, aprendeu a se comunicar movendo os olhos sobre um quadro de letras, mas depende muito dos cuidadores e da sua mulher, Jane.

Henry teve um vislumbre de um tipo de vida diferente quando viu Charlie Kemp na CNN em 2010. Kemp, professor de robótica na Georgia Tech, estava na televisão falando sobre o PR2, um robô desenvolvido pela empresa Willow Garage. O PR2 era uma máquina de dois braços sobre rodas que parecia um mordomo de metal em estado bruto. Kemp estava fazendo uma demonstração de como o robô funcionava e detalhando sua pesquisa sobre como os robôs de saúde poderiam ajudar as pessoas. Ele mostrou como o PR2 podia entregar alguns medicamentos ao apresentador de televisão.

“De repente, Henry se vira para mim e diz: ‘por que esse robô não pode ser uma extensão do meu corpo? E eu disse: ‘por que não?'”, conta Jane.

Havia um motivo sólido para não o fazer. Embora os engenheiros tenham feito grandes progressos para fazer com que os robôs trabalhem em ambientes rigidamente controlados, como laboratórios e fábricas, foi difícil projetá-los para o lar. No mundo real e bagunçado, os móveis e as plantas baixas são muito diferentes, crianças e animais de estimação podem atrapalhar o robô e as roupas que precisam ser dobradas têm formas, cores e tamanhos diferentes. O gerenciamento dessas configurações imprevisíveis e condições variadas está além das capacidades até mesmo dos protótipos mais avançados.

Isso parece estar finalmente mudando, em grande parte graças à Inteligência Artificial. Durante décadas, os roboticistas se concentraram mais ou menos no controle dos “corpos” dos robôs — seus braços, pernas, alavancas, rodas e similares — por meio de software orientado por objetivos. No entanto, uma nova geração de cientistas e inventores acredita que o ingrediente IA, até então ausente, pode dar aos robôs a capacidade de aprender novas habilidades e se adaptar a novos ambientes mais rapidamente do que nunca. Essa nova abordagem, talvez, possa finalmente levar os robôs para fora da fábrica e para nossas casas.

No entanto, o progresso não ocorrerá da noite para o dia, como os Evans sabem muito bem, devido aos muitos anos de uso de vários protótipos de robôs.

O PR2 foi o primeiro robô que eles trouxeram e abriu novas habilidades para Henry. Ele segurava um barbeador e Henry movia o rosto contra ele, o que lhe permitiu fazer a barba e se coçar sozinho pela primeira vez em uma década. Mas, com cerca de 200 quilos e US$ 400 mil, era difícil ter o robô por perto. “Ele poderia facilmente derrubar uma parede de casa”, diz Jane. “Eu não era uma grande fã.”

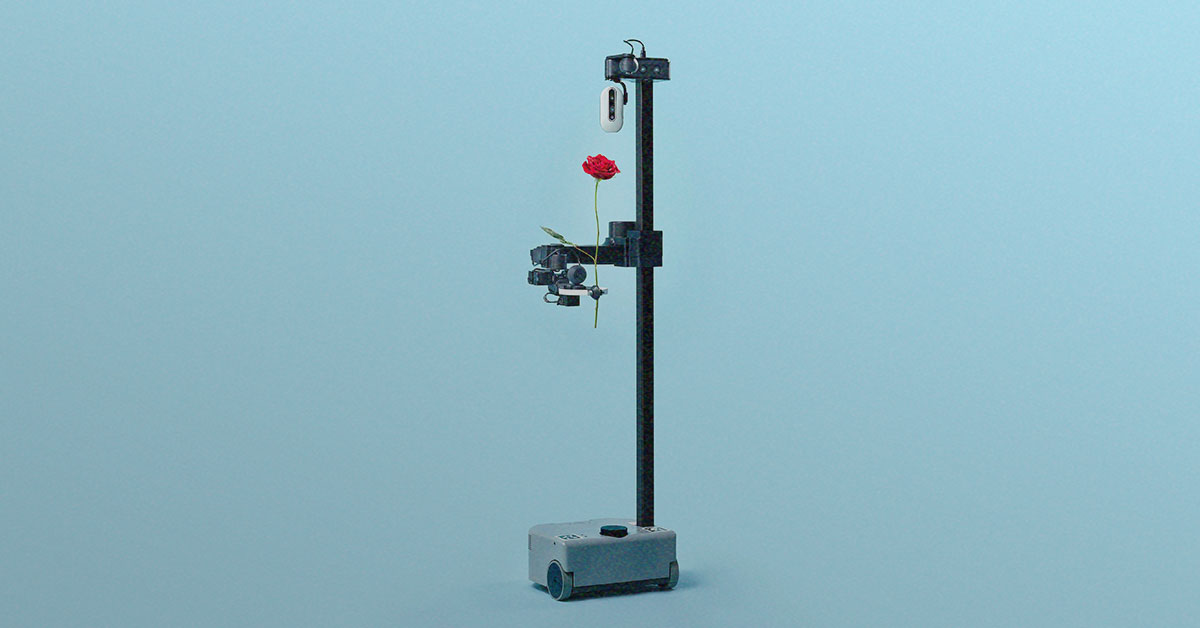

Mais recentemente, os Evans testaram um robô menor, chamado Stretch, que Kemp desenvolveu por meio de sua startup Hello Robot. A primeira iteração foi lançada durante a pandemia com um preço muito mais razoável, de cerca de US$ 18 mil.

O Stretch pesa cerca de 15 Kg. Ele tem uma pequena base móvel, um bastão com uma câmera pendurada e um braço ajustável com uma garra com ventosas nas extremidades. Ele pode ser controlado com um controlador de console. Henry controla o Stretch usando um laptop, com uma ferramenta que rastreia os movimentos de sua cabeça para mover um cursor. Ele é capaz de mover o polegar e o indicador o suficiente para clicar em um mouse de computador. No verão passado, ficou com o casal por mais de um mês e Henry diz que isso lhe proporcionou um nível totalmente novo de autonomia. “Era prático, e eu conseguia usá-lo todos os dias”, diz ele.

Henry Evans usou o robô Stretch para escovar o cabelo, comer e até brincar com sua neta.

Usando seu laptop, ele podia fazer com que o robô escovasse seu cabelo e que ele segurasse espetinhos de frutas para ele comer. Isso também abriu o relacionamento de Henry com sua neta Teddie. Antes, eles mal interagiam. “Ela não o abraçava em nenhuma despedida. Nada disso”, diz Jane. Mas “Papa Wheelie” e Teddie usaram Stretch para brincar, participando de corridas de revezamento, boliche e pesca magnética.

O Stretch não é muito inteligente: ele vem com alguns softwares pré-instalados, como a interface da Web que Henry usa para controlá-lo, e outros recursos, como a navegação habilitada para IA. A principal vantagem é que as pessoas podem conectar seus próprios modelos de IA e usá-los para fazer experimentos. Mas ele oferece um vislumbre de como poderia ser um mundo com robôs domésticos úteis. Os robôs que podem fazer muitas das coisas que os humanos fazem em casa — tarefas como dobrar a roupa, preparar refeições e limpar — têm sido o sonho da pesquisa em robótica desde o início da área, na década de 1950. Durante muito tempo, foi exatamente isso: “a robótica está cheia de sonhadores”, diz Kemp.

Mas o campo está em um ponto de inflexão, diz Ken Goldberg, professor de robótica da Universidade da Califórnia, em Berkeley. Segundo ele, as tentativas anteriores de criar um robô doméstico útil falharam enfaticamente em atender às expectativas estabelecidas pela cultura popular — pense na empregada robótica de Os Jetsons. Agora as coisas são muito diferentes. Graças ao hardware barato como o Stretch, juntamente com os esforços para coletar e compartilhar dados e os avanços na IA generativa, os robôs estão se tornando mais competentes e úteis mais rápido do que nunca. “Estamos em um ponto muito próximos de obter uma capacidade que será realmente útil”, diz Goldberg.

Dobrar a roupa, cozinhar camarão, limpar superfícies, descarregar cestas de compras — os robôs atuais, com tecnologia de IA, estão aprendendo a realizar tarefas que, para seus antecessores, teriam sido extremamente difíceis.

Peças que faltam

Há uma observação bem conhecida entre os especialistas em robótica: o que é difícil para os humanos é fácil para as máquinas, e o que é fácil para os humanos é difícil para as máquinas. Chamado de paradoxo de Moravec, foi articulado pela primeira vez na década de 1980 por Hans Moravec, o primeiro roboticista do Instituto de Robótica da Universidade Carnegie Mellon. Um robô pode jogar xadrez ou manter um objeto imóvel por horas a fio sem nenhum problema. Amarrar um cadarço, pegar uma bola ou conversar é outra questão.

Há três motivos para isso, diz Goldberg. Primeiro: os robôs não têm controle e coordenação precisos. Segundo: a compreensão do mundo ao redor é limitada, porque dependem de câmeras e sensores para percebê-lo. Terceiro: eles não têm um senso inato de física prática.

“Pegue um martelo e ele provavelmente cairá de sua garra, a menos que você o pegue perto da parte pesada. Mas você não saberá disso se apenas olhar para ele, a menos que saiba como os martelos funcionam”, diz Goldberg.

Além dessas considerações básicas, há muitos outros aspectos técnicos que precisam estar corretos, de motores a câmeras e conexões Wi-Fi, e o hardware pode ser proibitivamente caro.

Mecanicamente, já conseguimos fazer coisas bastante complexas há algum tempo. Em um vídeo de 1957, dois grandes braços robóticos são hábeis o suficiente para pegar um cigarro, colocá-lo na boca de uma mulher em uma máquina de escrever e reaplicar o batom. Mas a inteligência e a consciência espacial desse robô vieram da pessoa que o estava operando.

“A peça que falta é: como podemos fazer com que o software faça [essas coisas] automaticamente?”, diz Deepak Pathak, professor assistente de Ciência da Computação na Carnegie Mellon.

Tradicionalmente, os pesquisadores que treinam robôs têm abordado esse problema planejando tudo o que o robô faz em detalhes exaustivos. A gigante da robótica Boston Dynamics utilizou essa abordagem quando desenvolveu seu robô humanoide Atlas, que faz boogying e parkouring. As câmeras e a visão computacional são usadas para identificar objetos e cenas. Em seguida, os pesquisadores usam esses dados para criar modelos que podem ser usados para prever com extrema precisão o que acontecerá se um robô se mover de determinada maneira. Usando esses modelos, os roboticistas planejam os movimentos de suas máquinas escrevendo uma lista muito específica de ações a serem executadas. Em seguida, os engenheiros testam esses movimentos em laboratório várias vezes e os ajustam com perfeição.

Essa abordagem tem seus limites. Os robôs treinados dessa forma são estritamente coreografados para trabalhar em um ambiente específico. Se os tirarmos do laboratório e os levarmos para um local desconhecido, é provável que eles caiam.

Em comparação com outros campos, como a visão computacional, a robótica está na idade das trevas, diz Pathak. Mas esse pode não ser o caso por muito tempo, porque o campo está passando por uma grande mudança. Graças ao boom da IA, diz ele, o foco agora está mudando dos feitos de destreza física para a construção de “cérebros robóticos de uso geral” na forma de redes neurais. Assim como o cérebro humano é adaptável e pode controlar diferentes aspectos do corpo humano, essas redes podem ser adaptadas para funcionar em diferentes robôs e diferentes cenários. Os primeiros sinais desse trabalho mostram resultados promissores.

Robôs, conheça a IA

Durante muito tempo, a pesquisa em robótica foi um campo inflexível, atormentado por um progresso lento. No Instituto de Robótica da Carnegie Mellon, onde Pathak trabalha, ele diz que “costumava-se dizer que se você tocasse em um robô, acrescentaria um ano ao seu doutorado”. Agora, diz ele, os alunos são expostos a muitos robôs e veem os resultados em questão de semanas.

O que diferencia essa nova safra de robôs é o seu software. Em vez do tradicional planejamento e treinamento meticulosos, os roboticistas começaram a usar a aprendizagem profunda e as redes neurais para criar sistemas que aprendem com o ambiente em movimento e ajustam seu comportamento de acordo com ele. Ao mesmo tempo, um hardware novo e mais barato, como componentes prontos para uso e robôs como o Stretch, está tornando esse tipo de experimento mais acessível.

Em termos gerais, há duas maneiras populares pelas quais os pesquisadores estão usando a IA para treinar robôs. Pathak tem usado o aprendizado por reforço, uma técnica que permite que os sistemas melhorem por meio de tentativa e erro, para fazer com que os robôs adaptem seus movimentos em novos ambientes. Essa é uma técnica que a Boston Dynamics também começou a usar em seus “cães” robôs chamados Spot.

“PARKOUR EXTREMO COM ROBÔS COM PERNAS,” XUXIN CHENG, ET AL.

Em 2022, a equipe de Pathak usou esse método para criar “cães” robôs de quatro patas capazes de subir degraus e navegar em terrenos complicados. Primeiro, os robôs foram treinados para se movimentar em um simulador. Em seguida, eles foram soltos no mundo real, com uma única câmera embutida e um software de visão computadorizada para guiá-los. Outros robôs semelhantes dependem de mapas internos do mundo rigidamente prescritos e não conseguem navegar além deles.

Pathak diz que a abordagem da equipe foi inspirada na navegação humana.

Os seres humanos recebem informações sobre o mundo ao redor por meio de seus olhos, o que os ajuda a colocar instintivamente um pé na frente do outro para se locomover de maneira adequada. Normalmente, os seres humanos não olham para o chão sob seus pés quando andam, mas para alguns passos à frente, em um local para onde querem ir. A equipe de Pathak treinou seus robôs para adotar uma abordagem semelhante ao caminhar: cada um deles usou a câmera para olhar para frente. O robô foi capaz de memorizar o que estava à sua frente por tempo suficiente para orientar o posicionamento de suas pernas. Os robôs aprenderam sobre o mundo em tempo real, sem mapas internos, e ajustaram seu comportamento de acordo com isso. Na época, os especialistas disseram à MIT Technology Review que a técnica era um “avanço no aprendizado e na autonomia” e poderia permitir que os pesquisadores construíssem robôs com pernas capazes de serem utilizados na natureza.

Na outra técnica popular, chamada de aprendizagem por imitação, os modelos aprendem a executar tarefas, por exemplo, imitando as ações de um humano que teleopera um robô ou usando um fone de ouvido de realidade virtual para coletar dados. É uma técnica que entrou e saiu de moda ao longo de décadas, mas recentemente se tornou mais popular entre os robôs que realizam tarefas de manipulação, diz Russ Tedrake, vice-presidente de pesquisa de robótica do Toyota Research Institute e professor do MIT.

Ao associar essa técnica à IA generativa, os pesquisadores do Toyota Research Institute, da Universidade de Columbia e do MIT conseguiram ensinar rapidamente os robôs a realizarem muitas tarefas novas. Eles acreditam ter encontrado uma maneira de estender a tecnologia que impulsiona a IA generativa do domínio de textos, imagens e vídeos para o domínio dos movimentos dos robôs.

A ideia é começar com um humano, que controla manualmente o robô para demonstrar comportamentos como bater ovos ou pegar pratos. Usando uma técnica chamada política de difusão, o robô pode usar os dados fornecidos para aprender habilidades. Os pesquisadores ensinaram aos robôs mais de 200 habilidades, como descascar legumes e despejar líquidos, e dizem que estão trabalhando para ensinar mil habilidades até o final do ano.

Muitas outras empresas também aproveitaram as vantagens da IA generativa. A Covariant, uma startup que se originou da unidade de pesquisa de robótica da OpenAI, agora fechada, criou um modelo multimodal chamado RFM-1. Ele pode aceitar avisos na forma de texto, imagem, vídeo, instruções do robô ou medições. A IA generativa permite que o dispositivo entenda as instruções e gere imagens ou vídeos relacionados a essas tarefas.