Se você trabalha para o Bank of America ou para o Exército dos EUA, pode ter usado a tecnologia desenvolvida pela Humanyze. A empresa surgiu a partir de uma pesquisa interdisciplinar no Media Lab do MIT e descreve seus produtos como “análises com base científica para impulsionar a adaptabilidade”.

Se isso parece vago, pode ser deliberado. Entre as coisas que a Humanyze vende para empresas estão dispositivos para espionar funcionários, como crachás de identificação com etiquetas RFID (sigla em inglês para Radio frequency identification) embutidas, sensores de comunicação de campo próximo e microfones embutidos que rastreiam o tom e o volume em grandes detalhes (embora não as palavras reais) das conversas das pessoas ao longo do dia. A Humanyze registrou sua “Pontuação de Saúde Organizacional”, que faz um cálculo com base nos dados coletados nos crachás dos funcionários e que promete ser “uma fórmula comprovada para acelerar a mudança e impulsionar a melhoria”.

Ou talvez você trabalhe para uma das empresas de assistência médica, varejo ou serviços financeiros que usam software desenvolvido pela Receptiviti. A missão da empresa sediada em Toronto é “ajudar as máquinas a entender as pessoas”, digitalizando e-mails e mensagens do Slack em busca de dicas linguísticas de infelicidade. “Estamos preocupados com a percepção do “Grande Irmão””, disse recentemente o CEO da Receptiviti ao Wall Street Journal. Ele prefere chamar a vigilância de funcionários de “consciência corporativa”. (Orwell também teria algo a dizer sobre esse eufemismo.)

Esses esforços no que seus criadores chamam de “análise de pessoas” geralmente são justificados com base na melhoria da eficiência ou da experiência dos clientes. Nos últimos meses, alguns governos e especialistas em saúde pública defenderam o uso de aplicativos de rastreamento e localização de pessoas como um meio de impedir a disseminação da Covid-19.

Mas, ao adotar essas tecnologias, empresas e governos geralmente evitam responder a perguntas cruciais: Quem deve saber o que sobre você? O que eles sabem é correto? O que eles podem fazer com essas informações? E é possível conceber uma “fórmula comprovada” para avaliar o comportamento humano?

If Then: How the Simulmatics Corporation Invented the Future

Por Jill Lepore

W.W. NORTON

Essas questões têm uma história, mas os tecnólogos de hoje parecem não saber disso. Eles preferem se concentrar nas novas e engenhosas maneiras que suas invenções melhoram a experiência humana (ou resultados corporativos), em vez de nas formas como as pessoas em épocas anteriores tentaram fazer sem sucesso. Cada novo algoritmo ou aplicativo é, em sua opinião, uma repreensão implícita ao passado.

Mas esse passado pode oferecer uma espécie de guia e certa humildade muito necessárias. Apesar de hoje termos computadores mais rápidos e algoritmos mais sofisticados, a “análise de pessoas” é alimentada por um conceito redutor antigo: a noção de que a natureza humana em todas as suas complexidades pode ser reduzida a uma fórmula. Sabemos o suficiente sobre o comportamento humano para explorar as fraquezas uns dos outros, mas não o suficiente para mudá-lo significativamente, exceto talvez nas margens.

“If Then”, um novo livro de Jill Lepore, historiadora da Universidade de Harvard e redatora da New Yorker, conta a história de uma esquecida empresa de tecnologia de meados do século 20 chamada Simulmatics Corporation. Fundada por um grupo heterogêneo de cientistas e publicitários em 1959, era, afirma Lepore, a “Cambridge Analytica da Guerra Fria da dos Estados Unidos”.

Uma descrição mais precisa poderia ser que foi um esforço dos democratas para competir com a adoção das técnicas de publicidade do Partido Republicano. Em meados do século, os republicanos promoviam seus políticos ao público como se fossem papel higiênico ou café. A Simulmatics, que se instalou na cidade de Nova York (mas que tinha que pagar por hora para usar os computadores da IBM para executar seus cálculos), prometeu prever o resultado das eleições quase em tempo real – uma prática agora tão comum que é mundana, mas naquela época era vista como inovador, senão impossível.

O nome da empresa, uma combinação de palavras formada por “simulação” e “automático”, era um exemplo da ambição de seus criadores: “automatizar a simulação do comportamento humano.” Sua principal ferramenta era a People Machine (em tradução livre, Máquina de Pessoas), que Lepore descreve como “um programa de computador projetado para prever e manipular o todos os tipos de comportamento humano desde comprar uma máquina de lavar louça até combater uma insurgência e votar”. Funcionou desenvolvendo categorias de pessoas (como a mãe católica da classe trabalhadora branca ou republicana suburbana) e simulando sua provável tomada de decisão. (Hoje, a publicidade direcionada e as campanhas políticas usam técnicas altamente semelhantes.)

Os principais representantes da empresa vieram de diversos lugares. O publicitário Ed Greenfield foi um dos primeiros a vislumbrar como a nova tecnologia da televisão revolucionaria a política e se convenceu de que os primeiros computadores exerceriam uma força igualmente perturbadora na democracia. Ithiel de Sola Pool, um cientista social ambicioso e ansioso para trabalhar com o governo para descobrir os segredos do comportamento humano, acabou se tornando um dos primeiros teóricos prescientes das redes sociais.

Mais do que qualquer outra pessoa na Simulmatics, Pool incorporou tanto o fervor idealista quanto a negligência em quebrar as regras que caracterizam os inovadores de tecnologia de hoje. Filho de pais radicais, também se envolvera com o socialismo quando jovem e passou o resto da vida provando ser um patriota comprometido da Guerra Fria e certa vez descreveu seu trabalho com Simulmatics como “uma espécie de aposta do Projeto Manhattan na política”.

Um dos primeiros grandes clientes da empresa foi a campanha presidencial de John F. Kennedy em 1960. Quando Kennedy ganhou, a empresa reivindicou o crédito. Mas também enfrentou preocupações de que a máquina construída por ele pudesse ser usada para fins nefastos. Como um cientista disse em uma exposição da empresa na revista Harper’s publicada logo após a eleição, “Você não pode simular as consequências da simulação”. O público temia que empresas como a Simulmatics pudessem ter uma influência corruptora no processo democrático. Isso, lembre-se, foi quase meio século antes de o Facebook ser fundado.

Uma ramificação do governo, no entanto, estava entusiasmada com as capacidades de previsão da empresa: o Departamento de Defesa. Como Lepore lembra aos leitores, parcerias estreitas entre tecnólogos e o Pentágono eram vistas como esforços patrióticos necessários para conter a maré de comunismo durante a Guerra Fria.

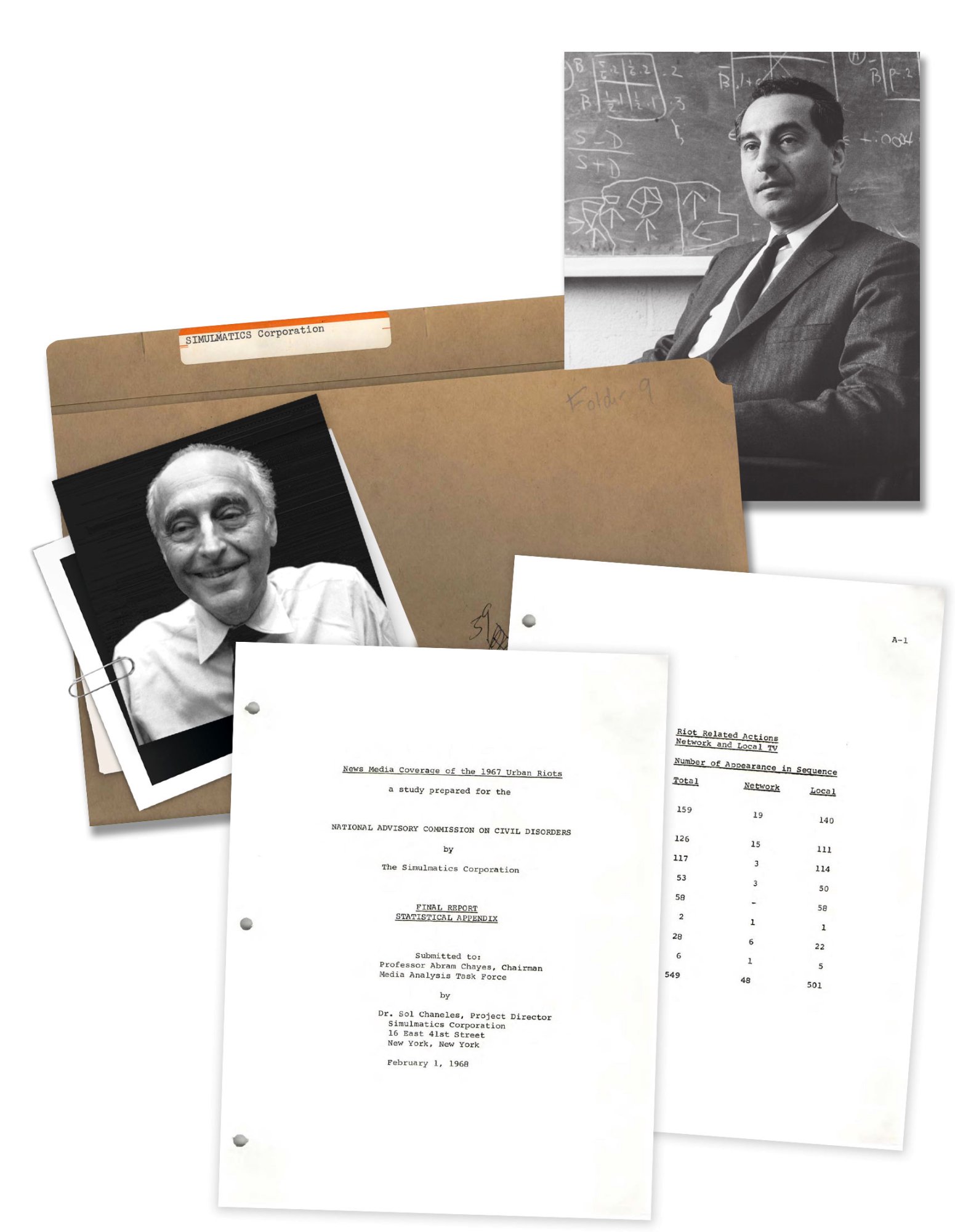

O cofundador da Simulatics, Ithiel de Sola Pool (à esquerda), certa vez descreveu seu trabalho como “uma espécie de” aposta do Projeto Manhattan na política”. A Comissão Kerner, convocada pelo presidente Lyndon Johnson em 1967 para estudar os distúrbios raciais que eclodiram em todo o país, pagou à Divisão de Estudos Urbanos da Simulmatics para desenvolver uma fórmula preditiva a esse tipo de situação.

MUSEU MIT (POOL); RICHARD RODSTEIN | WIKIMEDIA VIA CC SA (POOL, 1953); PASTA DA BIBLIOTECA PRESIDENCIAL DE LBJ: REGISTROS DO NACCD, SÉRIE 39, CAIXA 7

Em 1966, Pool aceitou um contrato para supervisionar um projeto de ciência comportamental em grande escala para o Departamento de Defesa de Saigon. “O Vietnã é o maior laboratório de ciências sociais que já tivemos!” ele se entusiasmou. Como o secretário de defesa Robert McNamara (a quem Barry Goldwater certa vez se referiu como “uma máquina IBM com pernas” e que encomendou a pesquisa), Pool acreditava que a guerra seria vencida nos “corações e mentes” dos vietnamitas, e que isso exigia modelagem e simulação de ciência comportamental para vencer. Como escreve Lepore, “Pool argumentou que embora os estadistas no passado tivessem consultado a filosofia, a literatura e a história, os estadistas da Guerra Fria eram obrigados a consultar as ciências do comportamento”.

Seus esforços de contra insurgência habilitada por computador foram um fracasso desastroso, em grande parte porque os dados da Simulmatics sobre os vietnamitas eram parciais e suas simulações baseadas mais em ilusões do que em realidades no terreno. Mas isso não impediu o governo federal de voltar a Pool e a Simulmatics para que eles ajudassem na compreensão – e previsão – de distúrbios civis em casa.

A Comissão Kerner, convocada pelo presidente Lyndon Johnson em 1967 para estudar os distúrbios raciais que eclodiram em todo o país, pagou à Divisão de Estudos Urbanos da Simulmatics para desenvolver uma fórmula preditiva para distúrbios a fim de alertar as autoridades sobre a agitação crescente antes que se tornasse desordem. Assim como as previsões para o Vietnã, essas também se mostraram duvidosas. Na década de 1970, a Simulmatics havia declarado falência e “a simulação computacional automatizada do comportamento humano caiu em descrédito”, de acordo com Lepore.

“A coleta e o uso de dados sobre o comportamento humano, com fins lucrativos, não regulamentados por qualquer órgão governamental, tem causado estragos nas sociedades humanas.”

A simulação “se esconde por trás da tela de cada dispositivo” que usamos, argumenta Lepore, e ela afirma que seus criadores, os “avós de bigodes brancos mortos há muito tempo de Mark Zuckerberg e Sergey Brin e Jeff Bezos e Peter Thiel e Marc Andreessen e Elon Musk,” são um “elo perdido” na história da tecnologia. Mas isso é um exagero. O sonho de classificar, categorizar e analisar pessoas tem sido uma constante ao longo da história. O esforço da Simulmatics foi apenas um entre muitos e dificilmente pode ser considerado como revolucionário.

Muito mais historicamente significativos (e prejudiciais) foram os projetos do século 19 para categorizar os criminosos ou as campanhas do início do século 20 para prever o comportamento com base em categorias pseudocientíficas de raça e etnia durante o auge do movimento eugênico. Todos esses projetos também contaram com a coleta e sistematização de dados e com parcerias com governos locais e estaduais para seu sucesso, mas também geraram muito entusiasmo de grande parte do público, algo que a Simulmatics nunca fez.

O que é verdade é que a combinação de idealismo e arrogância da Simulmatics é semelhante à de muitas empresas contemporâneas do Vale do Silício. Como eles, ela se via como a vanguarda de um novo Iluminismo, liderada pelas pessoas mais adequadas para resolver os problemas da sociedade, mesmo que não conseguissem compreender a complexidade e a diversidade dela. “Seria mais fácil, mais reconfortante, menos perturbador, se os cientistas da Simulmatics fossem vilões”, escreve Lepore. “Mas eles não eram. Eles eram liberais brancos de meados do século em uma época em que não se esperava que os liberais brancos entendessem as pessoas que não eram brancas ou liberais”. Da mesma forma que a Simulmatics Corporation acreditava que a mesma fórmula poderia entender populações tão distintas quanto eleitores americanos e aldeões vietnamitas, as tecnologias de previsão de hoje muitas vezes fazem promessas igualmente grandiosas. Alimentados por coleta e análise de dados muito mais sofisticados, eles ainda não conseguem levar em conta toda a gama e riqueza da complexidade e variação humana.

Portanto, embora Simulmatics não tenha, como afirma o subtítulo de Lepore, inventado o futuro, suas tentativas de categorizar e prever o comportamento humano levantaram questões sobre a ética dos dados que ainda estão conosco hoje. Lepore descreve as audiências no Congresso sobre privacidade de dados em 1966, quando um cientista da RAND delineou para o Congresso as perguntas que deveriam se fazer: “O que são dados? A quem eles pertencem? Que obrigação tem o coletor, ou detentor, ou analista de dados sobre o assunto? Os dados podem ser compartilhados? Eles podem ser vendidos?”

Lepore lamenta o fracasso de uma era anterior em enfrentar essas questões de frente. “Se, então, na década de 1960, as coisas tivessem acontecido de forma diferente, esse futuro poderia ter sido salvo”, ela escreve, acrescentando que “muitas pessoas na época acreditavam que uma máquina para analisar pessoas era total e absolutamente amoral”. Mas também é estranhamente reconfortante saber que, mesmo quando nossas tecnologias estavam em seus estágios rudimentares, as pessoas pensavam nas prováveis consequências de nosso uso.

Como Lepore escreve, Simulmatics foi prejudicada pelas limitações tecnológicas da década de 1960: “Os dados eram escassos. Os modelos, fracos. E os computadores lentos. A máquina falhou e os homens que a construíram não puderam repará-la”. Mas embora as máquinas de hoje sejam “mais elegantes, rápidas e aparentemente imparáveis”, elas não são fundamentalmente diferentes daquelas da Simulmatics. Ambas são baseadas na crença de que as leis matemáticas da natureza humana são reais, da mesma forma que as leis da física – uma falsa crença, observa Lepore:

O estudo do comportamento humano não é o mesmo que o estudo da propagação de vírus, da densidade das nuvens e do movimento das estrelas. O comportamento humano não segue leis como a lei da gravidade, e acreditar que sim é fazer um juramento a uma nova religião. A predestinação pode ser um evangelho perigoso. A coleta e o uso de dados sobre o comportamento humano, com fins lucrativos, não regulamentados por qualquer órgão governamental, tem causado estragos nas sociedades humanas, especialmente nas esferas em que a Simulmatics se engaja: política, publicidade, jornalismo, contra-insurgência e relações raciais.

Enquanto o Simulmatics falhou porque estava à frente de seu tempo, seus equivalentes modernos são mais poderosos e mais lucrativos. Mas lembrar sua história pode ajudar a esclarecer as deficiências de uma sociedade construída sobre crenças redutoras sobre o poder dos dados e iluminar um caminho em direção a um futuro humano digno, vibrante.