A pandemia da Covid-19 está levando os recursos hospitalares ao limite em muitos países do mundo. Não é nenhuma surpresa que muitas pessoas esperam que a IA possa acelerar a triagem de pacientes e aliviar a pressão sobre a equipe clínica. Mas um estudo do Google Health – o primeiro a analisar o impacto de uma ferramenta de deep learning em ambientes clínicos reais – revela que mesmo as IAs mais precisas podem, na verdade, piorar as coisas se não forem adaptadas à realidade na qual irão trabalhar.

As regras existentes para implantação de IA em ambientes clínicos, como os padrões para liberação da FDA nos EUA ou um selo CE na Europa, focam principalmente na precisão. Não há requisitos explícitos de que uma IA deve melhorar o resultado para os pacientes, principalmente porque esses testes ainda não foram executados. Mas isso precisa mudar, diz Emma Beede, pesquisadora de UX do Google Health: “Precisamos entender como as ferramentas de IA funcionarão para as pessoas em seu contexto, especialmente na área de saúde, antes de serem amplamente implantadas”.

A primeira oportunidade do Google de testar a ferramenta em um ambiente real veio da Tailândia. O ministério da saúde do país estabeleceu uma meta anual de examinar 60% das pessoas com diabetes em busca de retinopatia diabética (RD), que pode causar cegueira se não for diagnosticada precocemente. Mas com cerca de 4,5 milhões de pacientes para apenas 200 especialistas em retina – quase o dobro da proporção nos Estados Unidos – as clínicas estão lutando para atingir a meta. O Google tem a marca CE, que é válido na Tailândia, mas ainda está aguardando a aprovação do FDA. Então, para ver se a IA poderia ajudar, Beede e seus colegas equiparam 11 clínicas em todo o país com um sistema de deep learning treinado para detectar sinais de doenças oculares em pacientes com diabetes.

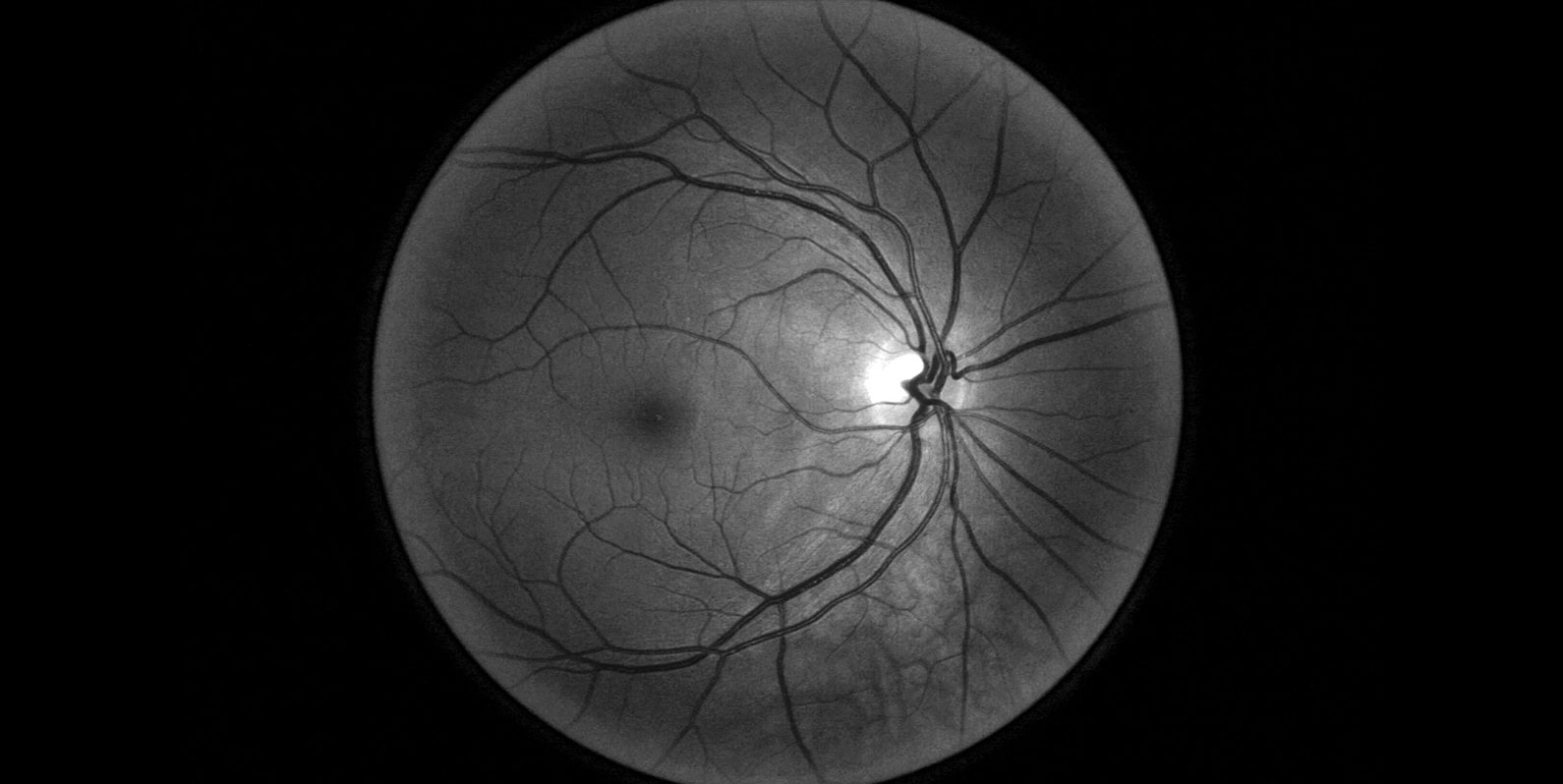

No sistema que a Tailândia estava usando, as enfermeiras tiram fotos dos olhos dos pacientes durante os check-ups e os enviam para serem examinados por um especialista em outro lugar – um processo que pode levar até 10 semanas. A IA desenvolvida pelo Google Health pode identificar sinais de RD em um exame ocular com mais de 90% de precisão – que a equipe chama de “nível de especialista humano” – e, teoricamente, dá um resultado em menos de 10 minutos. O sistema analisa as imagens em busca de indicadores reveladores da condição, como vasos sanguíneos bloqueados ou vazando.

Parece impressionante. Mas uma avaliação de precisão realizada em laboratório tem suas limitações. Não diz nada sobre como a IA funcionará no caos de um ambiente do mundo real, e isso é o que a equipe do Google Health queria descobrir. Durante vários meses, eles observaram enfermeiras realizando exames de vista e as entrevistaram sobre suas experiências com o uso do novo sistema. O feedback não foi exatamente positivo.

Quando funcionou bem, a IA acelerou as coisas. Mas, às vezes, não deu nenhum resultado. Como a maioria dos sistemas de reconhecimento de imagem, o modelo de deep learning foi treinado com imagens médicas de alta qualidade; para garantir a precisão, ele foi projetado para rejeitar aquelas que estavam abaixo de um certo padrão. Com enfermeiras examinando dezenas de pacientes por hora e muitas vezes tirando as fotos em condições de pouca iluminação, mais de um quinto das imagens foram rejeitadas.

Os pacientes cujas imagens foram recusadas do sistema foram informados que teriam que visitar um especialista em outra clínica em outro dia. O que era, obviamente, um inconveniente caso fosse difícil para eles tirarem uma folga do trabalho ou não tinham carro. As enfermeiras se sentiam frustradas, principalmente quando acreditavam que os exames rejeitados não mostravam sinais de doença e as consultas de acompanhamento eram desnecessárias. Às vezes, eles perdiam tempo tentando tirar outra foto ou editar uma imagem que a IA rejeitou.

Uma enfermeira opera o scanner de retina, tirando foto da parte de trás do olho do paciente. (Google)

Como o sistema teve que fazer upload de imagens para a nuvem para processamento, conexões de internet ruins em várias clínicas também causaram atrasos. “Os pacientes gostam dos resultados instantâneos, mas a internet é lenta e os pacientes reclamam”, disse uma enfermeira. “Eles estão esperando aqui desde às 6 da manhã, e nas primeiras duas horas nós só pudemos atender 10 pacientes”.

A equipe do Google Health agora está trabalhando com a equipe médica local para criar novos fluxos de trabalho. Por exemplo, os enfermeiros podem ser treinados para usar seu próprio julgamento em casos incertos. O próprio modelo também pode ser ajustado para lidar melhor com imagens imperfeitas.

Arriscando uma reação adversa

“Este é um estudo crucial para qualquer pessoa interessada em realmente atuar e implementar soluções de IA em ambientes do mundo real”, diz Hamid Tizhoosh, da Universidade de Waterloo, no Canadá, que trabalha com IA voltada para imagens médicas. Tizhoosh é muito crítico em relação ao que considera uma afobação em anunciar novas ferramentas de IA em resposta à Covid-19. Em alguns casos, ferramentas são desenvolvidas e modelos lançados por equipes sem experiência em saúde, diz ele. Ele vê o estudo do Google como um lembrete oportuno de que estabelecer a precisão em um laboratório é apenas a primeira etapa.

Michael Abramoff, um oftalmologista e cientista da computação da University of Iowa Hospitals and Clinics, vem desenvolvendo uma IA para diagnosticar doenças da retina há vários anos e é CEO de uma startup spinoff chamada IDx Technologies, que colaborou com IBM Watson. Abramoff foi apoiador do uso de IA na área de saúde no passado, mas ele também adverte contra a pressa, alertando sobre uma reação adversa se as pessoas tiverem experiências ruins com a Inteligência Artificial. “Estou muito feliz que o Google mostra que está disposto a analisar o fluxo de trabalho real nas clínicas”, diz ele. “Os cuidados de saúde vão muito além de algoritmos”.

Abramoff também questiona a utilidade de comparar ferramentas de IA com especialistas humanos quando se trata de precisão. Claro, não queremos que uma IA estrague tudo. Mas os médicos humanos discordam o tempo todo, diz ele – e tudo bem. Um sistema de IA deve se encaixar em um processo onde as fontes de incerteza são discutidas em vez de simplesmente descartadas.

Se você tiver sucesso, os benefícios podem ser enormes. Quando funcionava bem, Beede e seus colegas viram como a IA tornava ainda melhores as pessoas que eram boas em seus trabalhos. “Havia uma enfermeira que fez a triagem de 1.000 pacientes sozinha, e com essa ferramenta ela é irrefreável”, diz ela. “Os pacientes realmente não se importavam que fosse uma IA, em vez de um humano interpretando suas imagens. Eles se preocuparam mais em como sua experiência seria”.

Correção: a linha de abertura foi alterada para deixar claro que nem todos os países estão sendo sobrecarregados.