Em fevereiro do ano passado, o laboratório de pesquisa OpenAI, de São Francisco, anunciou que seu sistema de Inteligência Artificial (IA) agora poderia escrever passagens convincentes em inglês. Ao inserir o começo de uma frase ou parágrafo no GPT-2, como foi chamado, o sistema poderá continuar a ideia principal por tanto tempo quanto um ensaio com coerência quase humana.

Agora, o laboratório está explorando o que aconteceria se o mesmo algoritmo entrasse em contato com parte de uma imagem. Os resultados, que receberam uma menção honrosa de melhor artigo na International Conference on Machine Learning (ICML) em julho, abrem um novo caminho para a geração de imagens, repleto de oportunidades e consequências.

Em sua essência, o GPT-2 é um poderoso mecanismo de previsão. Ele aprendeu a compreender a estrutura da língua inglesa observando bilhões de exemplos de palavras, frases e parágrafos, retirados dos mais diversos recantos da internet. Com essa estrutura, ele poderia então manipular palavras em novas sentenças, prevendo estatisticamente a ordem em que deveriam aparecer.

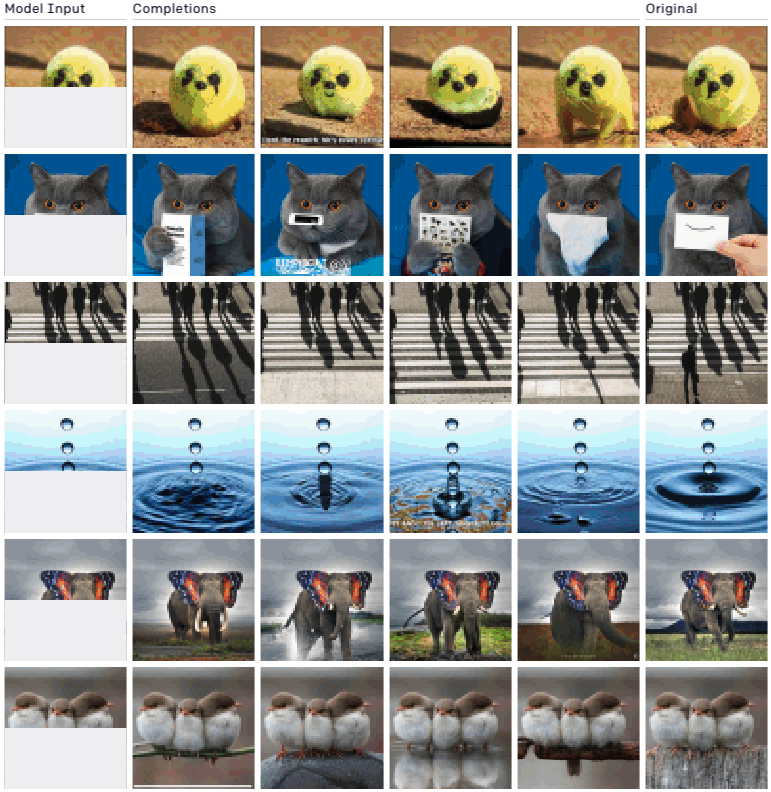

Então, pesquisadores da OpenAI decidiram trocar as palavras por pixels e treinar o mesmo algoritmo com imagens do ImageNet, o banco de imagens mais popular para deep learning. Como o algoritmo foi projetado para funcionar com dados unidimensionais (ou seja, sequências de texto), eles exibiram as imagens em uma única sequência de pixels. Eles descobriram que o novo modelo, denominado iGPT, ainda era capaz de compreender as estruturas bidimensionais do mundo visual. Dada a sequência de pixels para a primeira metade de uma imagem, ele poderia prever a segunda metade de maneiras que um ser humano consideraria sensato.

Abaixo, você pode ver alguns exemplos. A coluna mais à esquerda demonstra as imagens modelo inseridas, a coluna mais à direita é a original e as colunas do meio são as conclusões previstas do iGPT. (Veja mais exemplos aqui).

OPENAI

Os resultados são surpreendentemente impressionantes e demonstram um novo caminho para o uso de aprendizagem não supervisionada, treinado em dados não rotulados, no desenvolvimento de sistemas de visão computacional. Embora os primeiros sistemas em meados dos anos 2000 já testassem essas técnicas, elas caíram em desuso, pois o aprendizado supervisionado, que usa dados rotulados, provou ser muito mais bem-sucedido. O benefício do aprendizado não supervisionado, entretanto, é que ele permite que um sistema de IA aprenda sobre o mundo sem um filtro humano e reduz significativamente o trabalho manual de rotular os dados.

O fato de que iGPT usa o mesmo algoritmo do GPT-2 também mostra sua adaptabilidade promissora. Isso está de acordo com a ambição principal da OpenAI de alcançar uma IA mais generalizável.

Ao mesmo tempo, o método apresenta uma maneira preocupante de criar imagens altamente modificadas, conhecidas como deepfake. Redes generativas antagônicas (ou Generative Adversarial Network, GAN, em inglês), a categoria mais comum de algoritmos usados para criar deepfakes no passado, devem ser treinadas em dados extremamente selecionados. Se você deseja que um GAN gere uma rosto, por exemplo, seus dados de treinamento devem incluir apenas rostos. O iGPT, em contraste, simplesmente aprende o suficiente da estrutura do mundo visual por meio de milhões e bilhões de exemplos para criar imagens que poderiam existir dentro dele. Embora o treinamento do modelo ainda seja caro do ponto de vista computacional, oferecendo uma barreira natural para seu acesso, isso pode não ser o caso por muito tempo.

A OpenAI não respondeu a um pedido de entrevista, mas em uma reunião da equipe de política interna da qual a MIT Technology Review americana participou no ano passado, seu diretor, Jack Clark, refletiu sobre os riscos futuros da geração de algoritmos como o GPT, incluindo o que aconteceria se fosse aplicado a imagens. “O próximo passo será o vídeo”, disse ele, pensando por onde o campo de pesquisa avançaria. “Em provavelmente cinco anos, você terá a geração de vídeos de cinco a 10 segundos”. Ele então começou a descrever o que imaginou: você usaria uma foto de um político e uma explosão ao lado dele, por exemplo, e isso provavelmente resultaria em uma imagem desse político sendo morto.